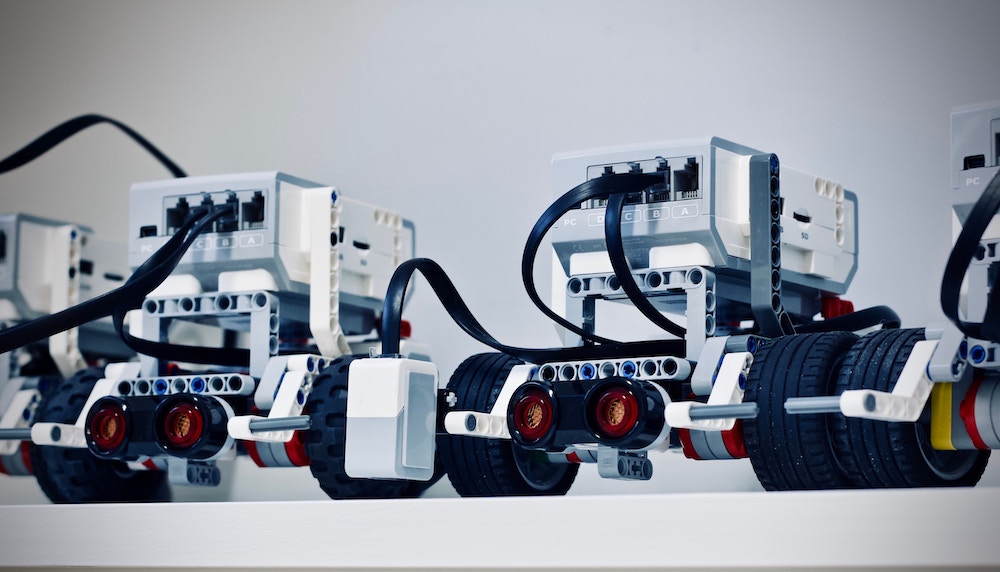

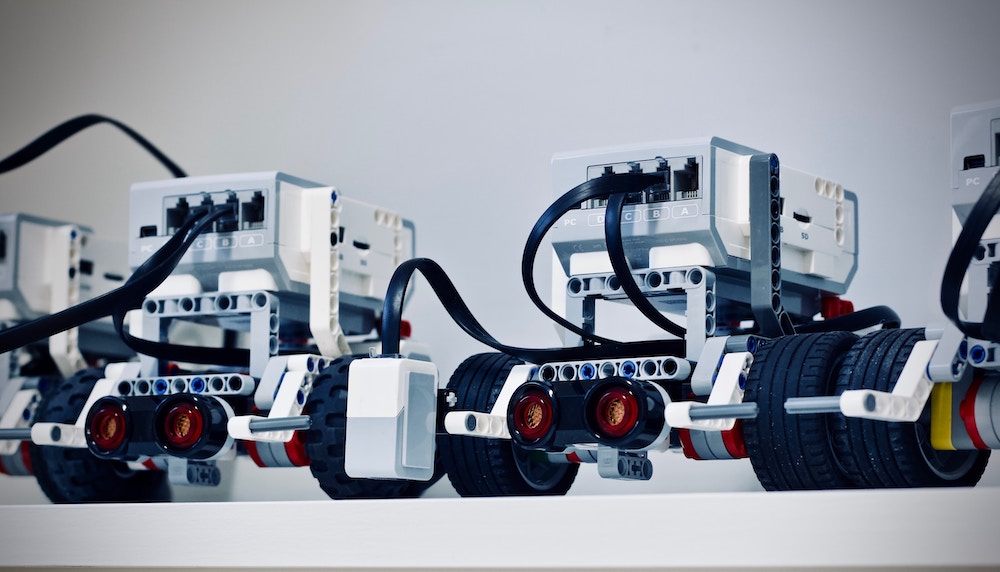

Photo by Jelleke Vanooteghem on Unsplash

En matière de RPA (Robotic Process Automation), la plupart des entreprises sont encore au stade de la validation, au travers de POC (proof of concept). Mais si le marché est encore émergent, il monte rapidement en puissance. Et pour cause. Les robots logiciels apportent avec eux la promesse de libérer les opérationnels de tâches chronophages et répétitives en les exécutant à leur place, plus vite et en limitant les erreurs de retranscription.

Les directions financières sont parmi les premières a s'être emparées du sujet pour automatiser certains de leurs processus en middle et back office et améliorer la productivité de leurs centres de services partagés. Selon une étude menée en Europe par ISG (Information Services Group), le taux d’entreprises utilisant la RPA pour dix processus métiers ou plus devrait doubler d'ici 2020. Au delà de la direction financière, les fonctions les plus impactées seraient le service client et le traitement des commandes, les achats, la logistique et la chaîne d’approvisionnement.

La RPA, performante mais pas magique

Pourquoi cet engouement ? Outre qu'il ne dort jamais, le robot est réputé exécuter les tâches sans erreur ou presque, permettant à l'humain de libérer du temps pour des tâches à plus forte valeur ajoutée.

Mais sont-ils 100 % plus sûrs ? La réponse est non. Si performante apparaît-elle, la technologie RPA n'est pas une baguette magique. Dénuée de toute fonction cognitive, elle ne fait qu'exécuter les instructions pour lesquelles elle est programmée. Les robots logiciels ne sont en particulier pas conçus pour jauger la qualité des informations qu'on leur donne à ingérer. S'ils sont alimentés avec de mauvaises données, le résultat en sortie de processus sera mécaniquement faussé. Produit plus vite, mais faussé. Il en est de même si le processus de création des données est lui-même facteur d’erreur : l’exécution sera … exactement fausse !

"Garbage in, garbage out" disent nos amis anglo-saxons. Si ce qui entre est mauvais, ce qui sort le sera aussi. A quoi bon automatiser la création de compte clients, si l'adresse client a été, à l'origine, mal saisie dans le système d'information de l'entreprise, ou si le client existe déjà ?

Le constater ne remet pas en cause les projets de robotisation. Mais leur mise en œuvre doit s'envisager de pair avec un travail de fond sur l'assainissement des données, à la source. Or, cette question de la qualité des données est encore trop rarement une priorité des entreprises, pour l'heure plutôt tournées vers les enjeux de RGPD (protection des données) et de sécurité. Pourtant, 25 % des données contenues dans un ERP seraient de mauvaise qualité. Et plus les données se massifient et se renouvellent, plus le risque d'occurrence d'anomalies devient élevé.

Alors que la data devient, dans nos entreprises digitalisées, une matière première aussi importante que le produit physique commercialisé, nous sommes loin, avec ces 25%, des standards recherchés dans le monde réel, industriel. La méthode Six Sigma, par exemple, encourage à tendre vers le zéro défaut, dans une régularité absolue, avec un taux de défaut de 3,4 pour un million d’unités produites. Si les instruments de mesure précise existaient, on constaterait que la gestion des données engendre, elle, un taux de rebut sans doute mille fois supérieur.

Un processus orienté sur la qualité des données

Pour relever ce défi, les entreprises doivent mettre en œuvre un processus orienté sur la qualité de la donnée et pas seulement sur son traitement. Et s'en assurer dès la collecte : vérifier son unicité, sa complétude, sa cohérence, gérer les taxonomies, etc.

C’est en instaurant des processus identifiables et mesurables, comme elle l’ont fait pour leurs chaines de fabrication, que les entreprises pourront atteindre les standards de qualité attendus. Les outils qui vont permettre aux opérationnels de répondre à ces défis devront avoir plusieurs types de fonctionnalités, parmi lesquelles la capacité à supporter un processus documenté, un contrôle qualité permanent et l’évolutivité du processus.

Le processus documenté sert à identifier les étapes théoriques et les étapes réelles, ainsi qu’à mesurer des temps. L'intérêt est de définir des étapes de fabrication (comme des sous-ensembles pour un produit manufacturé), afin de connaitre leur qualité et leur performance.

Le contrôle qualité permanent découle de cette approche : l’utilisateur peut se contrôler en permanence pour corriger ses erreurs, et une validation est réalisée en fin d’étape. Ainsi, il est possible de détecter les erreurs rapidement et de les corriger sur le champ.

Enfin, comme le processus est mesurable, tant dans son exécution que dans ses résultats, il est nécessaire de pouvoir le faire évoluer, pour le corriger, l’améliorer ou l’adapter à l’environnement.

Selon l'étude menée par ISG, quantité de processus métier sont des candidats éligibles à la robotisation. Intégrer la question de la qualité des données à la source est donc un enjeu phare, à l'échelle de l'entreprise. C'est à cette condition que la technologie RPA pourra réellement faire à la place de l'humain et surtout le faire mieux.

Les directions financières sont parmi les premières a s'être emparées du sujet pour automatiser certains de leurs processus en middle et back office et améliorer la productivité de leurs centres de services partagés. Selon une étude menée en Europe par ISG (Information Services Group), le taux d’entreprises utilisant la RPA pour dix processus métiers ou plus devrait doubler d'ici 2020. Au delà de la direction financière, les fonctions les plus impactées seraient le service client et le traitement des commandes, les achats, la logistique et la chaîne d’approvisionnement.

La RPA, performante mais pas magique

Pourquoi cet engouement ? Outre qu'il ne dort jamais, le robot est réputé exécuter les tâches sans erreur ou presque, permettant à l'humain de libérer du temps pour des tâches à plus forte valeur ajoutée.

Mais sont-ils 100 % plus sûrs ? La réponse est non. Si performante apparaît-elle, la technologie RPA n'est pas une baguette magique. Dénuée de toute fonction cognitive, elle ne fait qu'exécuter les instructions pour lesquelles elle est programmée. Les robots logiciels ne sont en particulier pas conçus pour jauger la qualité des informations qu'on leur donne à ingérer. S'ils sont alimentés avec de mauvaises données, le résultat en sortie de processus sera mécaniquement faussé. Produit plus vite, mais faussé. Il en est de même si le processus de création des données est lui-même facteur d’erreur : l’exécution sera … exactement fausse !

"Garbage in, garbage out" disent nos amis anglo-saxons. Si ce qui entre est mauvais, ce qui sort le sera aussi. A quoi bon automatiser la création de compte clients, si l'adresse client a été, à l'origine, mal saisie dans le système d'information de l'entreprise, ou si le client existe déjà ?

Le constater ne remet pas en cause les projets de robotisation. Mais leur mise en œuvre doit s'envisager de pair avec un travail de fond sur l'assainissement des données, à la source. Or, cette question de la qualité des données est encore trop rarement une priorité des entreprises, pour l'heure plutôt tournées vers les enjeux de RGPD (protection des données) et de sécurité. Pourtant, 25 % des données contenues dans un ERP seraient de mauvaise qualité. Et plus les données se massifient et se renouvellent, plus le risque d'occurrence d'anomalies devient élevé.

Alors que la data devient, dans nos entreprises digitalisées, une matière première aussi importante que le produit physique commercialisé, nous sommes loin, avec ces 25%, des standards recherchés dans le monde réel, industriel. La méthode Six Sigma, par exemple, encourage à tendre vers le zéro défaut, dans une régularité absolue, avec un taux de défaut de 3,4 pour un million d’unités produites. Si les instruments de mesure précise existaient, on constaterait que la gestion des données engendre, elle, un taux de rebut sans doute mille fois supérieur.

Un processus orienté sur la qualité des données

Pour relever ce défi, les entreprises doivent mettre en œuvre un processus orienté sur la qualité de la donnée et pas seulement sur son traitement. Et s'en assurer dès la collecte : vérifier son unicité, sa complétude, sa cohérence, gérer les taxonomies, etc.

C’est en instaurant des processus identifiables et mesurables, comme elle l’ont fait pour leurs chaines de fabrication, que les entreprises pourront atteindre les standards de qualité attendus. Les outils qui vont permettre aux opérationnels de répondre à ces défis devront avoir plusieurs types de fonctionnalités, parmi lesquelles la capacité à supporter un processus documenté, un contrôle qualité permanent et l’évolutivité du processus.

Le processus documenté sert à identifier les étapes théoriques et les étapes réelles, ainsi qu’à mesurer des temps. L'intérêt est de définir des étapes de fabrication (comme des sous-ensembles pour un produit manufacturé), afin de connaitre leur qualité et leur performance.

Le contrôle qualité permanent découle de cette approche : l’utilisateur peut se contrôler en permanence pour corriger ses erreurs, et une validation est réalisée en fin d’étape. Ainsi, il est possible de détecter les erreurs rapidement et de les corriger sur le champ.

Enfin, comme le processus est mesurable, tant dans son exécution que dans ses résultats, il est nécessaire de pouvoir le faire évoluer, pour le corriger, l’améliorer ou l’adapter à l’environnement.

Selon l'étude menée par ISG, quantité de processus métier sont des candidats éligibles à la robotisation. Intégrer la question de la qualité des données à la source est donc un enjeu phare, à l'échelle de l'entreprise. C'est à cette condition que la technologie RPA pourra réellement faire à la place de l'humain et surtout le faire mieux.

Autres articles

-

Face à l'iceberg Master Data, le rôle clé des utilisateurs métiers

-

La data, plus importante que le produit physique dans nombre de business modèles

-

Et si la robotisation en col blanc redonnait la part belle à l'humain ?

-

Gestion des données : pourquoi il faut s'intéresser à la valeur du temps

-

Gestion des données : gare aux coûts cachés qui minent la rentabilité