Revenons d'abord sur ce qu'est Data Explorer.

Jean-Pierre RIEHL, MVP SQL Server, Responsable Practice SQL/BI chez Azeo

Data Explorer a été officiellement présenté au PASS Summit en novembre dernier. C'est un outil qui permet la récupération et la transformation des données. Ça ressemble à un ETL à première vue mais regardons y de plus près.

L’outil est actuellement en phase de beta publique. Pour vous inscrire, c’est sur ce lien mais vous pouvez aussi commencer avec la version cliente

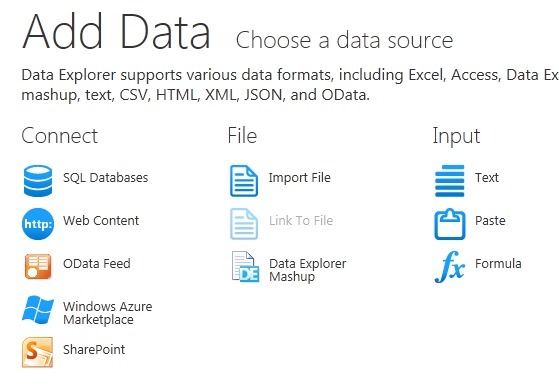

Comme tous les outils de la plate-forme Microsoft, on retrouve tout un tas de sources disponibles, des classiques aux plus exotiques comme un flux JSON ou du HTML par exemple.

L’outil est actuellement en phase de beta publique. Pour vous inscrire, c’est sur ce lien mais vous pouvez aussi commencer avec la version cliente

Comme tous les outils de la plate-forme Microsoft, on retrouve tout un tas de sources disponibles, des classiques aux plus exotiques comme un flux JSON ou du HTML par exemple.

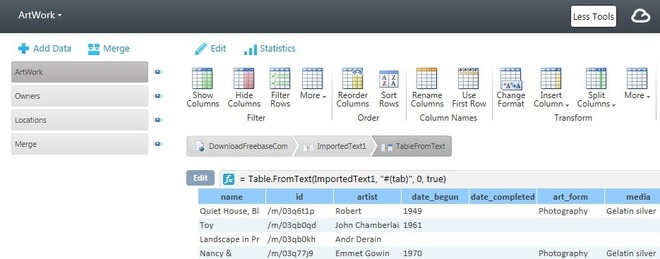

On peut ensuite appliquer tout un tas de transformations sur le "flux" et là on retrouve une boîte à outils tout aussi riche que celle de SSIS : filtres, colonne calculée, agrégation, dédoublonnage, tri, lookup, etc. On peut également unir ou fusionner des flux entre eux.

Tout cela nous permet de construire de réels mashups de données.

Jusque-là, on a tous les éléments d'un ETL donc qu'apporte en plus Data Explorer ?

La première chose qui nous saute aux yeux dès les premières manipulations est que tout se fait en direct au fil des clics.

Le flux reflète exactement le résultat de la transformation en temps réel dans une preview à l'écran.

Mais comment ça marche ?

Le geek que je suis a été très intrigué. En effet, on est plutôt habitué à devoir lancer tout le flux et attendre le résultat, bon ou pas bon. Certes, les ETL modernes, comme SSIS par exemple, possèdent des points d'arrêt mais on a pas une construction du résultat au gré du développement.

Le secret vient du modèle de développement retenu par Microsoft. Un DSL (Domain Specific Language, créé grâce au langage M de Microsoft) permet de construire le flux à la manière d'un langage comme LISP et donc d'avoir une exécution (évaluation ?) en live.

D'autant plus que l’outil tourne dans le Cloud avec toute la puissance de calcul de Azure.

À noter qu'il existe un client on-premises qui offre un accès plus simple aux bases locales (c’est possible depuis le cloud) et au système de fichiers.

Grâce au fonctionnement de Data Explorer, on peut donc construire son flux entièrement par code grâce à une API très riche, des lambdas expressions et un langage adapté (on parle d'ailleurs de formules).

Evidemment, l'interface, ses assistants et ses fenêtres de paramétrage rendent l'outil totalement à la portée d'utilisateurs métiers.

Ne parlez plus d’ETL

Le second point qui fait de Data Explorer un outil différent d'un ETL classique se passe dans le L de ETL. En effet, vous ne trouverez pas de tâches pour charger le flux dans une destination quelle qu’elle soit (SQL ou autre).

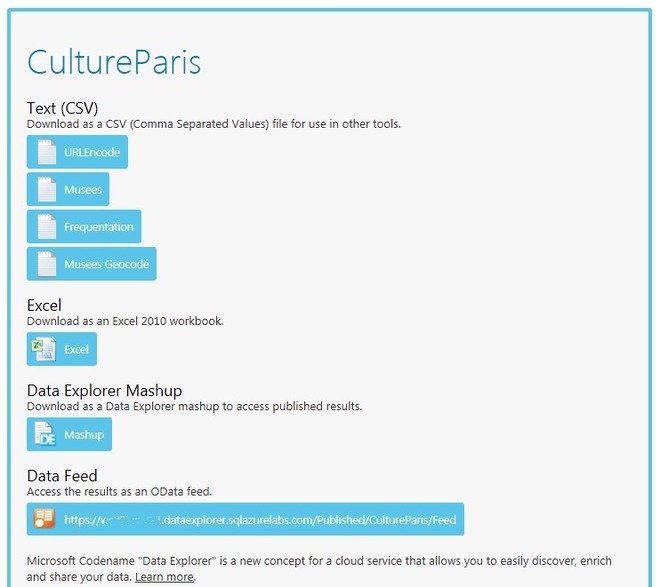

Data Explorer se qualifie comme un outil d'ETP : Extract, Transform, Publish.

Lorsque l'on a terminé son flux, on ne le charge pas, on le publie, sous différents formats (CSV, Excel, OData, etc.), afin qu'il soit disponible à d'autres outils qui en feront bon usage. On pense évidemment à tous les outils de Self-Service BI qui consomment des flux Odata par exemple (PowerPivot, Reporting Services).

Le flux reflète exactement le résultat de la transformation en temps réel dans une preview à l'écran.

Mais comment ça marche ?

Le geek que je suis a été très intrigué. En effet, on est plutôt habitué à devoir lancer tout le flux et attendre le résultat, bon ou pas bon. Certes, les ETL modernes, comme SSIS par exemple, possèdent des points d'arrêt mais on a pas une construction du résultat au gré du développement.

Le secret vient du modèle de développement retenu par Microsoft. Un DSL (Domain Specific Language, créé grâce au langage M de Microsoft) permet de construire le flux à la manière d'un langage comme LISP et donc d'avoir une exécution (évaluation ?) en live.

D'autant plus que l’outil tourne dans le Cloud avec toute la puissance de calcul de Azure.

À noter qu'il existe un client on-premises qui offre un accès plus simple aux bases locales (c’est possible depuis le cloud) et au système de fichiers.

Grâce au fonctionnement de Data Explorer, on peut donc construire son flux entièrement par code grâce à une API très riche, des lambdas expressions et un langage adapté (on parle d'ailleurs de formules).

Evidemment, l'interface, ses assistants et ses fenêtres de paramétrage rendent l'outil totalement à la portée d'utilisateurs métiers.

Ne parlez plus d’ETL

Le second point qui fait de Data Explorer un outil différent d'un ETL classique se passe dans le L de ETL. En effet, vous ne trouverez pas de tâches pour charger le flux dans une destination quelle qu’elle soit (SQL ou autre).

Data Explorer se qualifie comme un outil d'ETP : Extract, Transform, Publish.

Lorsque l'on a terminé son flux, on ne le charge pas, on le publie, sous différents formats (CSV, Excel, OData, etc.), afin qu'il soit disponible à d'autres outils qui en feront bon usage. On pense évidemment à tous les outils de Self-Service BI qui consomment des flux Odata par exemple (PowerPivot, Reporting Services).

Ce point important, additionné au fait que l'outil soit orienté utilisateur plutôt que développeur, classe Data Explorer dans la famille des outils de Self-Service BI en tant que Self-Service ETP.

Et dans l'offre décisionnelle de Microsoft, il manquait effectivement un outil qui permet aux utilisateurs de "modéliser" leurs données (cleansing, shaping) avant de les injecter dans un outil d'analyse ou de restitution.

Et dans l'offre décisionnelle de Microsoft, il manquait effectivement un outil qui permet aux utilisateurs de "modéliser" leurs données (cleansing, shaping) avant de les injecter dans un outil d'analyse ou de restitution.

OpenData ?

Le dernier point qui fait de Data Explorer un outil très intéressant est son ouverture aux marchés de données.

L'idée est de permettre à l'utilisateur d'intégrer dans ses données des données publiques (payantes ou gratuites) pour les enrichir.

Pour cela, il est possible de se brancher et de récupérer des données depuis le Azure Data Market, véritable place de marché d'échange de données

La version qui a été présentée au PASS Summit proposait même dynamiquement des données venant du Data Market en évaluant le contexte des données actuellement présentes dans le flux.

Par exemple, si vous avez une colonne qui contient des villes dans votre flux, l'outil le détecte et vous propose d'y adjoindre des données démographiques par exemple. Et cela sans métadonnées sur la colonne. On imagine aisément la pertinence d'un moteur de recherche comme Bing derrière pour comprendre que la colonne contient des villes et non des prénoms.

A noter que la version cliente de Data Explorer installe aussi un add-in à Excel pour faire le même type de propositions pour les données de vos classeurs.

En dehors du nettoyage et du formatage de son flux, c'est vraiment ce dernier point qui peut permettre de transformer les données d'entreprise en vrai pépite (et ainsi de trouver le poney caché à l'intérieur).

Sans nul doute, Data Explorer va trouver sa place dans l'offre décisionnelle de Microsoft et permettre à tout à chacun de révéler des trésors dans les données d'entreprises.

Vous pouvez venir découvrir Data Explorer aux TechDays, le grand événement annuel sur les technologies Microsoft, au stand SQL, au stand Azeo ou lors de la session dédiée à l'outil le jeudi 9 février à 11h. Suivez le programme !

L'idée est de permettre à l'utilisateur d'intégrer dans ses données des données publiques (payantes ou gratuites) pour les enrichir.

Pour cela, il est possible de se brancher et de récupérer des données depuis le Azure Data Market, véritable place de marché d'échange de données

La version qui a été présentée au PASS Summit proposait même dynamiquement des données venant du Data Market en évaluant le contexte des données actuellement présentes dans le flux.

Par exemple, si vous avez une colonne qui contient des villes dans votre flux, l'outil le détecte et vous propose d'y adjoindre des données démographiques par exemple. Et cela sans métadonnées sur la colonne. On imagine aisément la pertinence d'un moteur de recherche comme Bing derrière pour comprendre que la colonne contient des villes et non des prénoms.

A noter que la version cliente de Data Explorer installe aussi un add-in à Excel pour faire le même type de propositions pour les données de vos classeurs.

En dehors du nettoyage et du formatage de son flux, c'est vraiment ce dernier point qui peut permettre de transformer les données d'entreprise en vrai pépite (et ainsi de trouver le poney caché à l'intérieur).

Sans nul doute, Data Explorer va trouver sa place dans l'offre décisionnelle de Microsoft et permettre à tout à chacun de révéler des trésors dans les données d'entreprises.

Vous pouvez venir découvrir Data Explorer aux TechDays, le grand événement annuel sur les technologies Microsoft, au stand SQL, au stand Azeo ou lors de la session dédiée à l'outil le jeudi 9 février à 11h. Suivez le programme !

Pour en savoir plus sur l'auteur

Biographie de Jean-Pierre RIEHL

Après plusieurs années passées dans le développement Web et la forte volumétrie, Jean-Pierre entre dans le monde des SSII en 2006. Consultant, formateur et aussi manager, il est revenu à Paris en 2011 pour prendre la tête de la Practice SQL chez Azeo.

Tout au long de sa carrière, Jean-Pierre a travaillé avec SQL Server (depuis la version 7) aussi bien du côté des équipes de développement que de celles des administrateurs.

Il est plutôt orienté Business Intelligence. Le domaine des données d'entreprise le passionne comme l'Enterprise Integration Management (avec SSIS, MDS, DQS) ou la modélisation multidimensionnelle (avec Analysis Services et le MDX).

Malgré tout, ses missions préférées restent les audits de performances ou de sécurité SQL.

Jean-Pierre est très impliqué dans la communauté. Il est MVP depuis 2008 et speaker aux événements Microsoft depuis la même année

AZEO est une SSII pure-player Microsoft, focalisée sur l’expertise et la valeur ajoutée apportée à ses clients.

Fondée par des anciens Microsoftees, elle se positionne comme le partenaire privilégié pour vous accompagner sur l’appréhension et la mise en œuvre des technologies Microsoft dans votre système d’information.

AZEO est en forte croissance et regroupe à ce jour une trentaine d’experts sur SQL Server, Sharepoint, .NET, Windows Server, Intune, Office365, etc.

Plus d'informations :

http://www.azeo.com

http://blog.djeepy1.net

http://twitter.com/djeepy1

http://www.linkedin.com/in/djeepy1

Après plusieurs années passées dans le développement Web et la forte volumétrie, Jean-Pierre entre dans le monde des SSII en 2006. Consultant, formateur et aussi manager, il est revenu à Paris en 2011 pour prendre la tête de la Practice SQL chez Azeo.

Tout au long de sa carrière, Jean-Pierre a travaillé avec SQL Server (depuis la version 7) aussi bien du côté des équipes de développement que de celles des administrateurs.

Il est plutôt orienté Business Intelligence. Le domaine des données d'entreprise le passionne comme l'Enterprise Integration Management (avec SSIS, MDS, DQS) ou la modélisation multidimensionnelle (avec Analysis Services et le MDX).

Malgré tout, ses missions préférées restent les audits de performances ou de sécurité SQL.

Jean-Pierre est très impliqué dans la communauté. Il est MVP depuis 2008 et speaker aux événements Microsoft depuis la même année

AZEO est une SSII pure-player Microsoft, focalisée sur l’expertise et la valeur ajoutée apportée à ses clients.

Fondée par des anciens Microsoftees, elle se positionne comme le partenaire privilégié pour vous accompagner sur l’appréhension et la mise en œuvre des technologies Microsoft dans votre système d’information.

AZEO est en forte croissance et regroupe à ce jour une trentaine d’experts sur SQL Server, Sharepoint, .NET, Windows Server, Intune, Office365, etc.

Plus d'informations :

http://www.azeo.com

http://blog.djeepy1.net

http://twitter.com/djeepy1

http://www.linkedin.com/in/djeepy1

Autres articles

-

Celonis met à la disposition des clients de Microsoft Fabric sa Process Intelligence pour permettre une accélération de l'IA à grande échelle

-

Fivetran étend l’intégration de Microsoft Fabric avec plus de 700 connecteurs, facilitant la création de data lakes optimisés pour l’IA

-

Smart Global Governance lance Answer Writer : la nouvelle IA spécialisée dans l'automatisation des réponses aux questionnaires complexes (appels d'offres, sécurité, RSE)

-

Le Cube, le système décisionnel de Galileo Global Education, révélé par Claire Marchal

-

Oracle Database@Azure disponible dans de nouvelles régions et avec de nouveaux services pour répondre à la demande mondiale