Songdo, ville nouvelle à quelques dizaines de km de Seoul sera, lorsqu’elle sera achevée en 2015, la première Smart City sortie de terre dans une approche 100% Big Data.

Que ce soit Shanghai, Sao Paulo, ou… Paris, toutes les mégalopoles connaissent les mêmes problèmes : circulation automobile erratique, transports en commun engorgés, pollution permanente des centres villes, et pour certaines, réseaux électriques et des eaux défaillants. A part peut-être en Chine ou en Inde, difficile de faire aujourd’hui ce qu’avait réalisé le Baron Haussmann à Paris au XIXe siècle, démolir nos villes pour les réaménager de fond en comble. On ne peut agir que progressivement, et là où c’est le plus efficace. C’est ici que le numérique entre en jeu. Tout comme une entreprise doit songer à collecter ses données de production, ses données commerciales dans son entrepôt de données avant de mettre en place ses indicateurs de performance et songer à améliorer sa performance opérationnelle, les villes doivent capter en temps réel leurs données sur la circulation, la consommation électrique de chacun, la consommation en eau pour enfin évaluer les points d’amélioration où investir en priorité.

L’internet des objets va générer la matière première de la Smartcity : la donnée

EDF R&D a testé une architecture Hadoop pour consolider puis analyser les données que généreront les 35 millions de compteurs intelligents Linky.

L’exemple le plus emblématique de cette approche, sans nul doute le compteur électrique Linky d’ERDF. 35 millions de compteurs intelligents doivent être déployés en France d’ici 2020. Ces compteurs, plus communicants que réellement intelligents, vont transmettre, via courant porteur en ligne, des données de consommation à ERDF qui, en stockant cette donnée dans le temps va pouvoir optimiser la production électrique en faisant tourner des algorithmes prédictifs. Une donnée d’autant plus précieuse que, côté production, la montée en puissance des sources d’énergies renouvelables (type solaire ou éolienne) introduit une grande complexité de gestion. Le problème d’une telle approche est évident : 35 millions de compteurs qui envoient une mesure toutes les 10 minutes, c’est 1800 milliards d’enregistrements à stocker chaque année, soit 120 To de données brutes. Face à ce déluge à venir, EDF R&D a lancé le projet Sigma pour évaluer l’architecture technique qui allait à la fois stocker ces données et permettre leur analyse prédictive : Marie-Luce Picard, chef de projet chez EDF R&D en souligne les enjeux « Il nous faut bâtir un data warehouse opérationnel avec, à la fois un très large volume de données qui l’alimente plusieurs fois par jour, mais aussi être capable de traiter un très grand nombre de requêtes tactiques, prédéfinie et aussi des requêtes non prévues ». Dans une « preuve de concept » menée sur une grappe de 36 nœuds, EDF R&D a validé qu’une architecture Hadoop allait pouvoir tenir la charge : des analyses de données stockées sur Hive délivrait des résultats dans les délais imposés par le contrat de service.

Tableau de bord délivré par l’application Vizelia, aujourd’hui Schneider Electrique, à partir des données de consommations collectées en M2M

Ce qu’EDF veut faire au niveau national, des entreprises, des collectivités le font à leur niveau. Une startup comme Vizelia, rachetée par Schneider Electrique en 2010 équipe les entreprises de capteurs de température, de consommation énergétique et de consommation d’eau et stocke sur sa plateforme afin de délivrer via le web des tableaux de bord de consommation. Les données peuvent être corrélées avec celles de la météo locale, et un algorithme détermine l’empreinte CO2 du bâtiment.

Des algorithmes pour optimiser la circulation automobile

Le trafic routier de la ville de Rio de Janeiro lors de la prochaine coupe de monde de Football puis les Jeux Olympique de 2016 sera piloté par les algorithmes prédictifs d’IBM.

L’engorgement des centres villes et des grandes artères est un souci de pratiquement toutes les mégalopoles au monde. Rio de Janeiro, qui se prépare à accueillir la prochaine coupe du monde de Football mais aussi les Jeux Olympiques, a fait appel à IBM pour calculer de nouveaux plans de circulation de secours pendant cette période. Non seulement la cité brésilienne, qui compte près de 12 millions d’habitants, est l’objet d’une congestion automobile chronique, mais son réseau routier est fréquemment victime d’inondations et de glissements de terrain. Pour la ville, IBM a développé un système de gestion de la voirie pour améliorer la gestion des travaux dans la cité, a mis en place un système de gestion du trafic routier s’appuyant notamment sur le réseau des caméras de la ville et donc un volet prédictif pour déployer les moyens d’intervention d’urgence et redéployer le trafic en cas d’incident sur le réseau routier. Un système qui risque d’être très sollicité pour les JO de Rio 2016.

Des sources de données parfois inattendues

Si un gestionnaire d’infrastructure tel que Cofely Ineo fait converger vers sa plateforme OPENcontrol les données générées par ses applications et capteurs, les données issues de la ville ou encore les données mises à disposition des citoyens dans le cadre des initiatives Open Data ; certains s’appuient sur des sources de données parfois inattendues. Ainsi, Orange commercialise les informations de position de ses 27 millions d’abonnés mobile en France, des données anonymisées, bien évidemment, mais précises : « On a fait un effort conséquent, en plaçant des sondes dans notre réseau à plusieurs niveaux pour être capables d’extraire des trajectoires, où vont les gens, des types d’activités » explique Roland Airiau, directeur de recherche chez Orange Labs, « des informations tout à fait intéressantes pour les collectivités locales, le géomarketing ».

D’autres vont aller chercher l’information là où les habitants s’expriment, c’est-à-dire sur les médias sociaux. Certaines villes commencent à analyser les tweets, les interventions sur Facebook et les billets de blogs pour savoir ce que pensent leurs habitants de telle ou telle infrastructure publique. Avec son offre IBM Social Media Analytics, l’américain a exploité sa technologie d’analyse des sentiments sur les médias sociaux en Inde où elle a pu montrer que les transports collectifs de Mumbai, pourtant légendaires, suscitent deux fois moins de commentaires négatifs que ceux de Bangalore et de New Delhi.

D’autres vont aller chercher l’information là où les habitants s’expriment, c’est-à-dire sur les médias sociaux. Certaines villes commencent à analyser les tweets, les interventions sur Facebook et les billets de blogs pour savoir ce que pensent leurs habitants de telle ou telle infrastructure publique. Avec son offre IBM Social Media Analytics, l’américain a exploité sa technologie d’analyse des sentiments sur les médias sociaux en Inde où elle a pu montrer que les transports collectifs de Mumbai, pourtant légendaires, suscitent deux fois moins de commentaires négatifs que ceux de Bangalore et de New Delhi.

Le Big Data pour une ville plus sûre

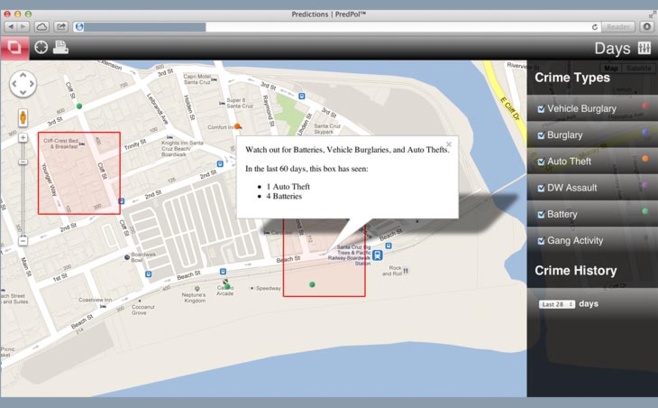

Le logiciel Predpol indique les zones à surveiller d’après l’analyse de l’historique des crimes dans la ville.

Ce mouvement vers les données volumineuses a été engagé par de nombreuses villes pour améliorer la sécurité dans les rues, à l’image de Vancouver qui, exploite le système Consolidated Records Intelligence Mining Environment (CRIME). Ce logiciel, qui associe la plateforme géographique ESRI et les données consolidées par IBM, a pu analyser les crimes & délits passés pour définir les lieux à surveiller en priorité. Un groupe de chercheurs de l’UCLA, mené par le professeur Jeff Brantingham est allé plus loin en analysant 13 millions de crimes. Avec l’aide du mathématicien George Mohler de l’université de Santa Clara, ils ont appliqué sur ce corpus crapuleux les algorithmes prédictifs dérivés de ceux annonçant les répliques d’un tremblement de terre. Le logiciel, exploité par la police de Los Angeles, est maintenant capable de définir une zone de quelques centaines de m2 où un crime devrait se produire dans les 12 heures.

Cette technologie, qui n’est pas sans rappeler la police du pré-crime de Minority Report, ne doit rien à la science fiction et a aujourd’hui quitté le monde de la recherche purement universitaire. La solution, baptisée Predpol, est bel et bien commercialisée et peut se targuer de résultats significatifs sur le terrain, preuve, s’il en faut encore, que le Big Data impacte déjà nos villes.

Cette technologie, qui n’est pas sans rappeler la police du pré-crime de Minority Report, ne doit rien à la science fiction et a aujourd’hui quitté le monde de la recherche purement universitaire. La solution, baptisée Predpol, est bel et bien commercialisée et peut se targuer de résultats significatifs sur le terrain, preuve, s’il en faut encore, que le Big Data impacte déjà nos villes.

Autres articles

-

L'industrie automobile en plein changement : 80 % des véhicules seront évolutifs par les mises à jour des logiciels qui le constituent et intégreront de l’intelligence artificielle à l’horizon 2035

-

Orange Business lance « Live Intelligence » : une gamme de solutions clés en main d’accès à l'IA générative pour les entreprises

-

IBM choisi comme partenaire officiel de la Scuderia Ferrari HP pour l'engagement des fans et l'analyse des données

-

IBM présente Granite 3.0 : des modèles d'IA performants conçus pour les entreprises

-

L’alliance entre l'innovation d'une start-up et l’industrialisation d’une grande entreprise : IBM met le modèle « Large » de Mistral à disposition sur watsonx