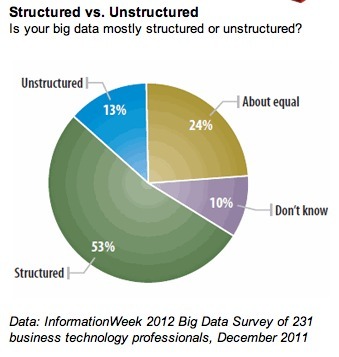

L'étude date un peu (décembre 2011), publiée par InformationWeek. Mais elle donne un point de départ.

En décembre 2011, 53 % des personnes interrogées (attention, 231 répondants seulement) indiquaient que leur "big data" étaient essentiellement composées de données structurées. Tout le monde n'est en effet pas encore passé à l'analyse des véritables données non structurées. Même les plus grands comme Facebook, Twitter, Google, analysent essentiellement des données structurées, même s'ils stockent et manipulent également de gros volumes de données non structurées.

Prenons l'exemple de Facebook, collecter une image chargée par un utilisateur consiste juste à manipuler un fichier image, pas la peine de chercher à le "comprendre". Il ne s'agit là que de données structurées associées à un fichier image.

Mais lorsque Facebook se lance dans la reconnaissance de visages, là, on passe à l'analyse de données non structurées.

Même chose avec un statut. Le stocker dans une base de données n'est pas compliqué. C'est juste un champ texte et des méta-données. Mais tenter d'en analyser le contenu pour "comprendre" ce que l'utilisateur a voulu dire, c'est autre chose.

Face à l'absence de définition claire des périmètres, les répondants aux sondages ont alors tendance à répondre "ce qui les met en valeur". D'où les résultats de cette enquête qui fait ressortir que 13 % des personnes interrogées ont un entrepôt de données composé essentiellement de données non structurées, et 24 % où la répartition structurées / non structurées est équitable. Ce qui me semble énorme, et complètement déconnecté de la réalité des entreprises que je rencontre.

Sauf si tous les champs "texte" comme une adresse, un nom, un commentaire.. sont considérés comme "non structuré" ! Facile alors de parvenir à ces chiffres. Mais on n'aura finalement rien appris...

En décembre 2011, 53 % des personnes interrogées (attention, 231 répondants seulement) indiquaient que leur "big data" étaient essentiellement composées de données structurées. Tout le monde n'est en effet pas encore passé à l'analyse des véritables données non structurées. Même les plus grands comme Facebook, Twitter, Google, analysent essentiellement des données structurées, même s'ils stockent et manipulent également de gros volumes de données non structurées.

Prenons l'exemple de Facebook, collecter une image chargée par un utilisateur consiste juste à manipuler un fichier image, pas la peine de chercher à le "comprendre". Il ne s'agit là que de données structurées associées à un fichier image.

Mais lorsque Facebook se lance dans la reconnaissance de visages, là, on passe à l'analyse de données non structurées.

Même chose avec un statut. Le stocker dans une base de données n'est pas compliqué. C'est juste un champ texte et des méta-données. Mais tenter d'en analyser le contenu pour "comprendre" ce que l'utilisateur a voulu dire, c'est autre chose.

Face à l'absence de définition claire des périmètres, les répondants aux sondages ont alors tendance à répondre "ce qui les met en valeur". D'où les résultats de cette enquête qui fait ressortir que 13 % des personnes interrogées ont un entrepôt de données composé essentiellement de données non structurées, et 24 % où la répartition structurées / non structurées est équitable. Ce qui me semble énorme, et complètement déconnecté de la réalité des entreprises que je rencontre.

Sauf si tous les champs "texte" comme une adresse, un nom, un commentaire.. sont considérés comme "non structuré" ! Facile alors de parvenir à ces chiffres. Mais on n'aura finalement rien appris...