Passer de Microsoft Excel à l’analyse prédictive

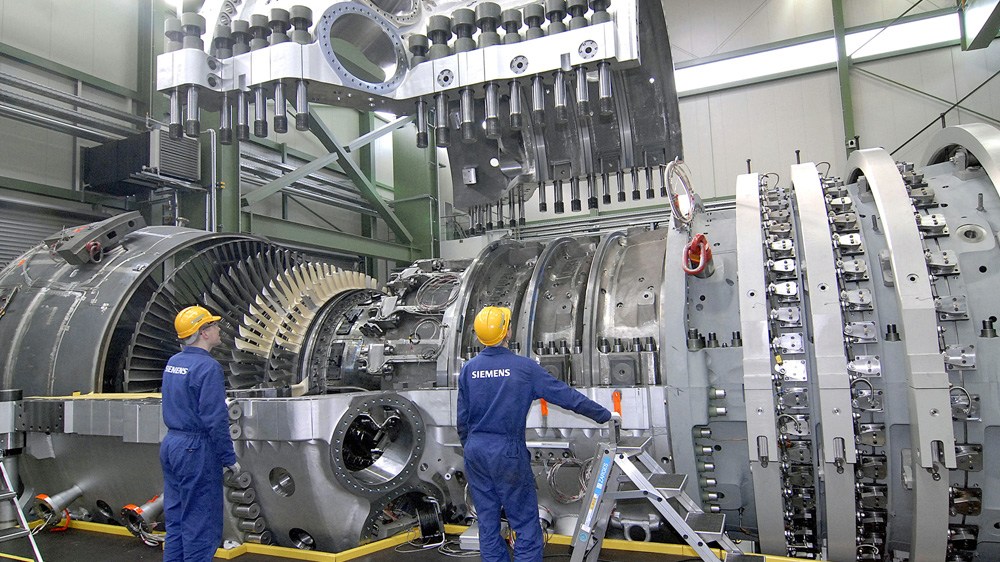

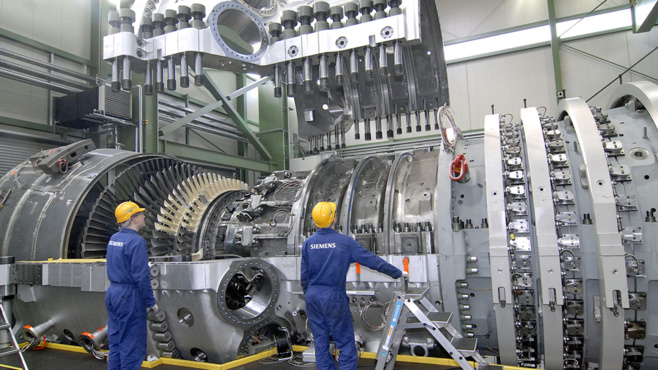

Le marché de la fourniture d’énergie, est comme tous les autres secteurs, concerné par une évolution de ses modèles économiques. Les clients de Siemens, producteurs d’électricité, doivent faire face à plusieurs évolutions de leur secteur : des sources d’énergie plus décentralisées et plus fluctuantes, la production à la commande, la personnalisation de masse, le développement de la maintenance prédictive, et de machines capables de s’auto-diagnostiquer et d’être réparées à distance. Répondre à ces enjeux de leurs clients, signifie pour Siemens le développement de nouveaux logiciels, et l’évolution vers une offre de services plus complète. Le client n’achète plus simplement une turbine à gaz, mais le service qui consiste à la maintenir à sa pleine capacité de production. “L’électrification, l’automatisation, et la digitalisation, sont les objectifs de croissance à long terme de Siemens”, explique Bruce Baum, Big Data Architect chez Siemens.

Penchons nous aujourd’hui sur une application précise, celle qui consiste à optimiser le fonctionnement, comprendre et prédire les incidents, sur les turbines industrielles à gaz. Chaque turbine installée est maintenant équipée de 5000 capteurs, chacun capable de générer jusqu’à une donnée par seconde. L’architecture logicielle s’appuie sur des réseaux de neurones pour analyser les données générées.

Au coeur de cette l’analyse, la maintenance prédictive. Mais l’usure de pièces mécaniques n’est pas une science exacte que l’on saurait parfaitement modéliser. Les ingénieurs doivent donc trouver des corrélations entre les données non structurées collectées, les données opérationnelles, et des mesures précises manuelles de l’usure de certaines pièces. Une fois les corrélations statistiques découvertes, il faut calculer et prévoir les meilleurs fréquences de remplacement de chaque pièce : trop tard, on risque la panne et ses conséquences financières; trop tôt, le coût augmente.

L’infrastructure mise en place par Siemens permet d’automatiser et de perfectionner toutes les phases de collecte et d’analyse de données, qui étaient encore il y a peu de temps, réalisées largement manuellement, sous Excel !

Chaque turbine peut être analysée sur l’ensemble de son cycle de vie, soit en conservant les données pendant plus de dix ans. Les données peuvent maintenant être stockées par milliards et analysées sur de plus longues périodes que précédemment. La période d’analyse était auparavant limitée à deux mois.

Et surtout, ce n’est plus aux analystes à collecter et organiser les données; le système le fait pour eux, et ils peuvent se consacrer à l’analyse des données produites. Avec le système précédent, une journée était occupée chaque semaine par la préparation des données.

Penchons nous aujourd’hui sur une application précise, celle qui consiste à optimiser le fonctionnement, comprendre et prédire les incidents, sur les turbines industrielles à gaz. Chaque turbine installée est maintenant équipée de 5000 capteurs, chacun capable de générer jusqu’à une donnée par seconde. L’architecture logicielle s’appuie sur des réseaux de neurones pour analyser les données générées.

Au coeur de cette l’analyse, la maintenance prédictive. Mais l’usure de pièces mécaniques n’est pas une science exacte que l’on saurait parfaitement modéliser. Les ingénieurs doivent donc trouver des corrélations entre les données non structurées collectées, les données opérationnelles, et des mesures précises manuelles de l’usure de certaines pièces. Une fois les corrélations statistiques découvertes, il faut calculer et prévoir les meilleurs fréquences de remplacement de chaque pièce : trop tard, on risque la panne et ses conséquences financières; trop tôt, le coût augmente.

L’infrastructure mise en place par Siemens permet d’automatiser et de perfectionner toutes les phases de collecte et d’analyse de données, qui étaient encore il y a peu de temps, réalisées largement manuellement, sous Excel !

Chaque turbine peut être analysée sur l’ensemble de son cycle de vie, soit en conservant les données pendant plus de dix ans. Les données peuvent maintenant être stockées par milliards et analysées sur de plus longues périodes que précédemment. La période d’analyse était auparavant limitée à deux mois.

Et surtout, ce n’est plus aux analystes à collecter et organiser les données; le système le fait pour eux, et ils peuvent se consacrer à l’analyse des données produites. Avec le système précédent, une journée était occupée chaque semaine par la préparation des données.

Une architecture “Big Data”

Bruce Baum, Big Data Architect chez Siemens partage son expérience à la conférence Teradata Partners 2016

Les volumes de données sont importants, et générés en flux continu. Ces turbines à gaz fonctionnent 24h/24, et ce sont donc 432 millions de données qui peuvent être générées chaque jour par chaque turbine. Siemens a mis en place un lac de données (data lake) dans Hadoop, qui stocke aujourd’hui plus de 300 milliards de lignes de données. Suivant le principe du lac de données, c’est un “schema on read” qui est appliqué. C’est à dire que les données sont simplement déposées dans HDFS, sans modélisation. C’est à la lecture des données que le modèle sera construit. C’est un petit peu plus long lors de la phase de lecture, mais selon Siemens, c’est indispensable pour préserver la qualité des données d’un flux d’une telle ampleur.

C’est ensuite dans un traitement par lots que les données sont sélectionnées et déplacées de Hadoop vers Teradata. Siemens utilise alors la solution d’intégration de données Teradata QueryGrid, qui permettrait de traiter jusqu’à 10 To de données par seconde. Sur les 300 milliards d’informations stockées dans Hadoop, seules 75 milliards sont conservées et intégrées dans l’entrepôt de données Teradata. Plusieurs étapes permettent de raffiner les données, jusqu’à un data mart qui ne contient plus que 30 millions de lignes. L’outil Teradata BTEQ participe également à ces phases de chargement / transformation.

Le data mart construit au dessus des données brutes est multidimensionnel. Il combine les données et les met à disposition des utilisateurs, qui peuvent soit lancer leurs requêtes, soit utiliser un outil de visualisation graphique comme Tableau, qui dispose d’un connecteur avec Teradata.

C’est ensuite dans un traitement par lots que les données sont sélectionnées et déplacées de Hadoop vers Teradata. Siemens utilise alors la solution d’intégration de données Teradata QueryGrid, qui permettrait de traiter jusqu’à 10 To de données par seconde. Sur les 300 milliards d’informations stockées dans Hadoop, seules 75 milliards sont conservées et intégrées dans l’entrepôt de données Teradata. Plusieurs étapes permettent de raffiner les données, jusqu’à un data mart qui ne contient plus que 30 millions de lignes. L’outil Teradata BTEQ participe également à ces phases de chargement / transformation.

Le data mart construit au dessus des données brutes est multidimensionnel. Il combine les données et les met à disposition des utilisateurs, qui peuvent soit lancer leurs requêtes, soit utiliser un outil de visualisation graphique comme Tableau, qui dispose d’un connecteur avec Teradata.

Particularités des données des capteurs

Croire que chaque capteur envoie religieusement, une donnée à chaque seconde, et que 5000 capteurs vont être parfaitement synchronisés et enverront des données cadencées… c’est un peu croire au Père Noël ! La réalité du monde des capteurs est toute autre.

D’abord une donnée issue d’un capteur ne fait sens, que replacée dans son contexte. Si un capteur indique une température de 120°, cela peut être énorme dans certains contextes, tout à fait normal dans un autre, et très inférieur à la norme dans un troisième contexte. Les données peuvent ensuite être envoyées à des rythmes différents, et il est illusoire d’espérer les recevoir de manière synchronisée.

Enfin, certains capteurs n’envoient une information que lorsque la donnée change; ou même lorsqu’elle évolue d’un certain pourcentage. Le reste du temps, le capteur est silencieux, indiquant ainsi que la dernière donnée est toujours valide. Mais ces “trous noirs” dans l’émission de données sont parfois difficiles à interpréter; comment faire la différence entre un capteur silencieux et un capteur avec lequel on a perdu la connexion. Pour une même turbine, certains capteurs peuvent envoyer quelques données par jour, d’autres plusieurs milliers d’informations.

Il est donc nécessaire d’aligner les variables entre elles, afin de repérer les anomalies éventuelles et de comparer des éléments comparables. Selon Siemens, cet alignement des données temporelles représente une réelle difficulté avec les langages traditionnels de programmation et les bases de données habituelles. Un traitement doit donc être réalisé en amont, afin d’aligner les informations.

Et cela passe par l’utilisation d’un nouveau type de données : “Period Data Type”, composé d’une paire d’horodatage, le point de début et le point de fin. Ce type de données, utilisé ensuite dans les requêtes SQL, permet d’aligner les données de tous les capteurs d’une même période. Au sein d’une requête SQL, les périodes peuvent être croisées, pour répondre à des interrogations précises.

Le travail de l’équipe “architecture” s’arrête à la mise à disposition des données, validées et organisées, nettoyées et au bon format, qui sont ensuite récupérées par l’équipe d’analyse de données.

D’abord une donnée issue d’un capteur ne fait sens, que replacée dans son contexte. Si un capteur indique une température de 120°, cela peut être énorme dans certains contextes, tout à fait normal dans un autre, et très inférieur à la norme dans un troisième contexte. Les données peuvent ensuite être envoyées à des rythmes différents, et il est illusoire d’espérer les recevoir de manière synchronisée.

Enfin, certains capteurs n’envoient une information que lorsque la donnée change; ou même lorsqu’elle évolue d’un certain pourcentage. Le reste du temps, le capteur est silencieux, indiquant ainsi que la dernière donnée est toujours valide. Mais ces “trous noirs” dans l’émission de données sont parfois difficiles à interpréter; comment faire la différence entre un capteur silencieux et un capteur avec lequel on a perdu la connexion. Pour une même turbine, certains capteurs peuvent envoyer quelques données par jour, d’autres plusieurs milliers d’informations.

Il est donc nécessaire d’aligner les variables entre elles, afin de repérer les anomalies éventuelles et de comparer des éléments comparables. Selon Siemens, cet alignement des données temporelles représente une réelle difficulté avec les langages traditionnels de programmation et les bases de données habituelles. Un traitement doit donc être réalisé en amont, afin d’aligner les informations.

Et cela passe par l’utilisation d’un nouveau type de données : “Period Data Type”, composé d’une paire d’horodatage, le point de début et le point de fin. Ce type de données, utilisé ensuite dans les requêtes SQL, permet d’aligner les données de tous les capteurs d’une même période. Au sein d’une requête SQL, les périodes peuvent être croisées, pour répondre à des interrogations précises.

Le travail de l’équipe “architecture” s’arrête à la mise à disposition des données, validées et organisées, nettoyées et au bon format, qui sont ensuite récupérées par l’équipe d’analyse de données.

Autres articles

-

Teradata lance des cas d’usage d’IA générative à démarrage rapide grâce à l’intégration d’Amazon Bedrock

-

Teradata nomme Louis Landry au poste de Chief Technology Officer

-

Teradata AI Unlimited pour Microsoft Fabric est désormais disponible en avant-première via Microsoft Fabric Workload Hub

-

Teradata facilite l’application concrète de l’IA générative et accélère la création de valeur pour les entreprises

-

Teradata propose des capacités d’IA exceptionnelles pour les grandes entreprises et les environnements hybrides en collaboration avec NVIDIA