Ainsi, la quête d'un modèle parfait est une chimère. Dans la réalité d'un projet, la réalisation d'un modèle de Machine Learning est toujours perfectible. D'autre part, pour chaque cas d'usage, les méthodes de travail et algorithmes utilisés pourrons être complètement différents. Dans certains cas ils pourront être très performants et pour le cas suivant s'avérer très décevants. En fonction de son expérience, le Data Scientist devra adapter ses outils aux cas qu'il aura à traiter, sans jamais être sûr de la meilleure solution. A titre d'illustration, il n'est pas rare que les champions de compétitions Kaggle.com se retrouvent parfois en queue de classement. Il faut donc aborder cette discipline avec beaucoup d'humilité.

Fort de ce constat, les entreprises désireuses, à juste titre, de se lancer dans la Data Science doivent être vigilantes à certains écueils.

L'auto-satisfaction : Il est fréquent que de simples modèles de machine learning apportent rapidement une amélioration significative par rapport aux méthodes traditionnelles.

Peut-on faire bien mieux avec un peu plus de temps? Sans doute.

La quête du modèle parfait : A l'opposé, dans le cadre de compétitions, certaines équipes de Data Scientists peuvent passer plusieurs mois à tuner des modèles, pour ne gagner que quelques millièmes de performance.

Peut-on aller plus vite pour des performances proches? Sans doute.

Fort de ce constat, les entreprises désireuses, à juste titre, de se lancer dans la Data Science doivent être vigilantes à certains écueils.

L'auto-satisfaction : Il est fréquent que de simples modèles de machine learning apportent rapidement une amélioration significative par rapport aux méthodes traditionnelles.

Peut-on faire bien mieux avec un peu plus de temps? Sans doute.

La quête du modèle parfait : A l'opposé, dans le cadre de compétitions, certaines équipes de Data Scientists peuvent passer plusieurs mois à tuner des modèles, pour ne gagner que quelques millièmes de performance.

Peut-on aller plus vite pour des performances proches? Sans doute.

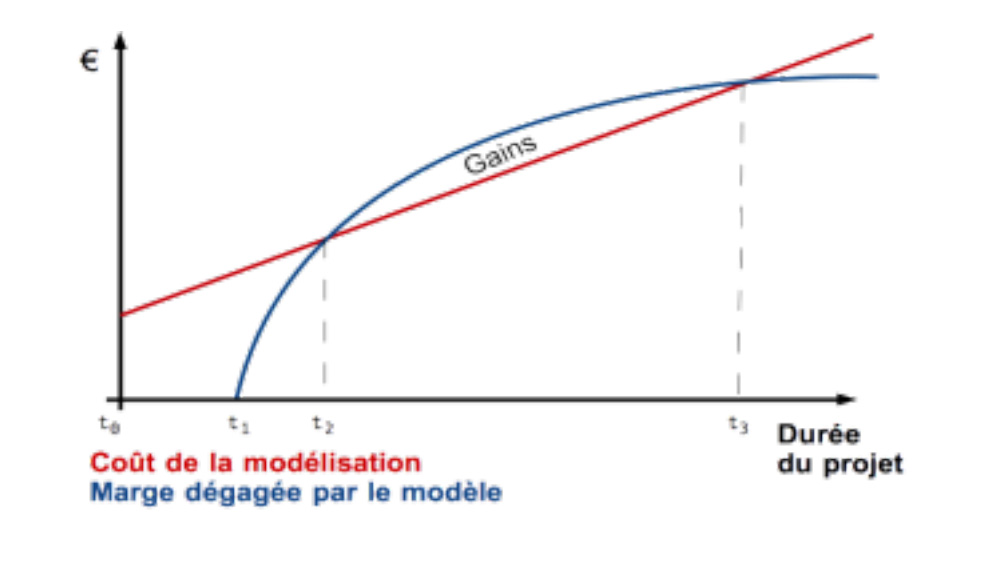

t, est la durée passée à créer un modèle, plus la durée est longue, meilleur est le modèle. Meilleur le modèle est, plus les retours attendus (gains) sont élevés, mais plus il est coûteux.

- t0 : initialisation du projet, mobilisation de l'équipe de Data Scientists

- t0 → t1 : préparation du modèle le plus simple avant sa mise en production

- t1 : mise en production du modèle

- t2 → t3 : Les modèles mis en production sont (marginalement) rentables. Les gains d'un modèle plus performant couvrent et dépassent les coûts du temps passé à le produire.

- Au delà de t3, les modèles mis en production ne sont marginalement plus rentables. Les gains d'un modèle plus performant ne couvrent pas les coûts du temps passer à le produire.

Ainsi, il s'agit de trouver le bon équilibre entre temps passé à modéliser et performance du modèle. A cet égard, l'intervention ponctuelle d'une deuxième équipe permet de challenger la première. Au delà du challenge à relever entre les deux équipes et la stimulation positive qui doit en ressortir, cela permet de fixer des repères et de bencher ses modèles. Comme nous avons pu le voir plus haut, des méthodes de travail et des algorithmes distincts peuvent aboutir à des performances significativement différentes, difficiles à évaluer a priori.

Nous préconisons ainsi l'intervention en « Fast-Track » d'une équipe tierce, interne ou externe, avec d'autres méthodes et outils, afin d'éviter l'auto-satisfaction et d’arrêter la course à la performance sans ROI.

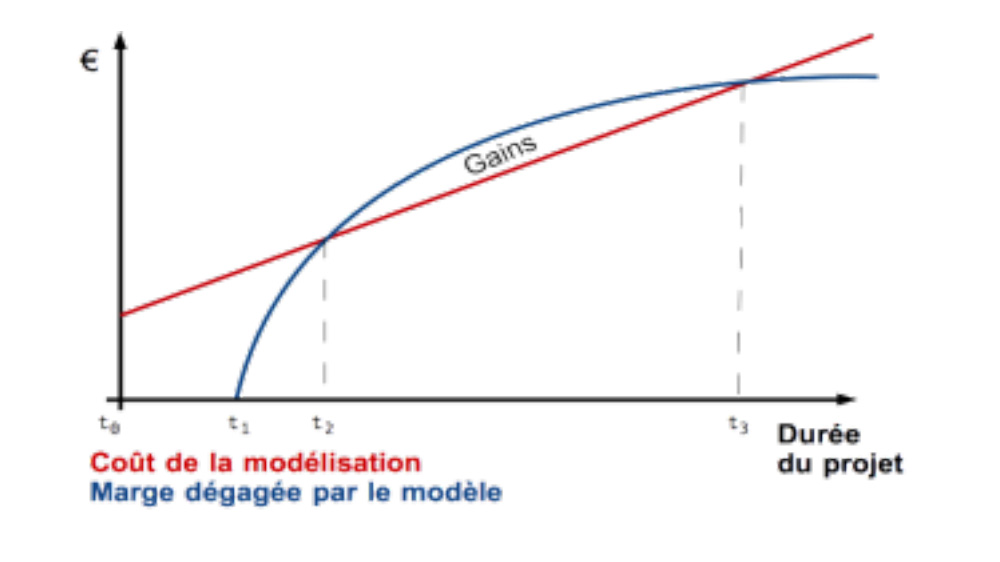

- t0 : initialisation du projet, mobilisation de l'équipe de Data Scientists

- t0 → t1 : préparation du modèle le plus simple avant sa mise en production

- t1 : mise en production du modèle

- t2 → t3 : Les modèles mis en production sont (marginalement) rentables. Les gains d'un modèle plus performant couvrent et dépassent les coûts du temps passé à le produire.

- Au delà de t3, les modèles mis en production ne sont marginalement plus rentables. Les gains d'un modèle plus performant ne couvrent pas les coûts du temps passer à le produire.

Ainsi, il s'agit de trouver le bon équilibre entre temps passé à modéliser et performance du modèle. A cet égard, l'intervention ponctuelle d'une deuxième équipe permet de challenger la première. Au delà du challenge à relever entre les deux équipes et la stimulation positive qui doit en ressortir, cela permet de fixer des repères et de bencher ses modèles. Comme nous avons pu le voir plus haut, des méthodes de travail et des algorithmes distincts peuvent aboutir à des performances significativement différentes, difficiles à évaluer a priori.

Nous préconisons ainsi l'intervention en « Fast-Track » d'une équipe tierce, interne ou externe, avec d'autres méthodes et outils, afin d'éviter l'auto-satisfaction et d’arrêter la course à la performance sans ROI.

Autres articles