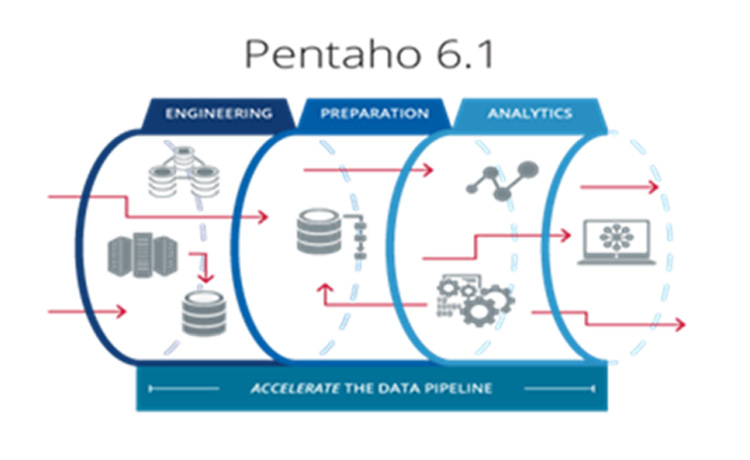

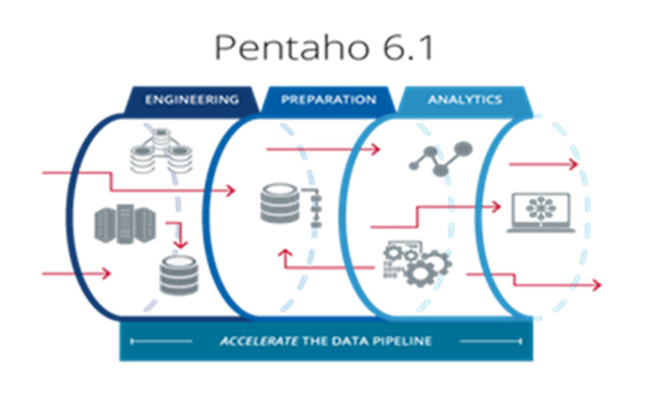

Fournisseur de solutions analytiques modernes, Pentaho, société du groupe Hitachi, annonce l’ajout de nouvelles fonctionnalités à sa solution innovante d’injection de métadonnées, qui contribuent à réduire considérablement le temps de développement lors d’intégration de données, aussi bien dans des environnements traditionnels que dans des environnements Hadoop. Disponible dès aujourd’hui, Pentaho 6.1 accélère le pipeline d’analyse des Big Data en simplifiant ce processus complexe et en ajoutant des fonctionnalités permettant une analyse des Big Data à grande échelle automatisée et plus agile.

Résoudre le goulot d’étranglement le plus laborieux du pipeline des Big Data

L’intégration moderne de Big Data ne se limite pas au chargement ou au transfert de données. Cela implique de gérer un ensemble de sources de données en constante évolution, de capturer des métadonnées, de reproduire des processus à grande échelle et de garantir un contrôle et une gouvernance. Ces défis sont amplifiés dans des environnements Big Data tel qu’Hadoop.

Avec Pentaho 6.1, les équipes informatiques confrontées aux difficultés de l’intégration des données disposent désormais d’un large éventail d’options pour transférer de manière dynamique des métadonnées vers Pentaho Data Integration au moment de l’exécution, afin de contrôler une logique complexe de transformation. Les équipes peuvent à présent exécuter des centaines de processus d’ingestion et de préparation de données en opérant seulement quelques transformations, ce qui accélère fortement la mise à disposition d’ensembles de données gouvernées prêtes à l’analyse pour en extraire des informations détaillées. L’intégration des données est généralement un processus manuel, répétitif et source d’erreurs qui crée un goulot d’étranglement dans le pipeline des données. Avant la solution d’injection des données de Pentaho, les entreprises ne pouvaient éviter ce goulot d’étranglement qu’en allouant d’importantes ressources d’ingénierie de données internes.

Résoudre le goulot d’étranglement le plus laborieux du pipeline des Big Data

L’intégration moderne de Big Data ne se limite pas au chargement ou au transfert de données. Cela implique de gérer un ensemble de sources de données en constante évolution, de capturer des métadonnées, de reproduire des processus à grande échelle et de garantir un contrôle et une gouvernance. Ces défis sont amplifiés dans des environnements Big Data tel qu’Hadoop.

Avec Pentaho 6.1, les équipes informatiques confrontées aux difficultés de l’intégration des données disposent désormais d’un large éventail d’options pour transférer de manière dynamique des métadonnées vers Pentaho Data Integration au moment de l’exécution, afin de contrôler une logique complexe de transformation. Les équipes peuvent à présent exécuter des centaines de processus d’ingestion et de préparation de données en opérant seulement quelques transformations, ce qui accélère fortement la mise à disposition d’ensembles de données gouvernées prêtes à l’analyse pour en extraire des informations détaillées. L’intégration des données est généralement un processus manuel, répétitif et source d’erreurs qui crée un goulot d’étranglement dans le pipeline des données. Avant la solution d’injection des données de Pentaho, les entreprises ne pouvaient éviter ce goulot d’étranglement qu’en allouant d’importantes ressources d’ingénierie de données internes.

Nouveau projet type pour l’intégration des données en libre-service

Outre les nouvelles fonctionnalités de la version 6.1, Pentaho a créé un nouveau projet type d’intégration des données en libre-service. Ce nouveau processus structuré permet aux clients et utilisateurs métier d’intégrer eux-mêmes une grande variété de données sans aucune aide de l’équipe informatique, ce qui simplifie le processus d’ingestion des données. La fonctionnalité d’injection de métadonnées de Pentaho est au cœur de ce dernier projet type de Pentaho.

Un client de Pentaho, Kingland Systems, fournit des applications de gestion des données dédiées au secteur de la finance. Selon Matt Good, directeur de l’Architecture logicielle, Kingland Systems, « Pentaho permet à notre solution de simplifier le processus d’intégration des données pour nos clients, leur permettant ainsi d’intégrer des données de différents systèmes et formats dans notre solution. La suppression des goulots d’étranglement inhérents à l’intégration manuelle des données a grandement contribué au succès de notre solution, offrant une rapidité et un niveau de précision qui satisfont les besoins en matière de gestion et d’analyse des données de nos clients. »

Meilleures agilité, collaboration et flexibilité pour des analyses des Big Data plus performantes

Les nouvelles fonctionnalités de la plateforme d’intégration et d’analyse des données Pentaho 6.1 aident les entreprises à configurer leurs pipelines de données pour prendre en charge un volume, une variété et une complexité des données toujours plus importants. Les principales nouvelles caractéristiques sont les suivantes :

· Améliorations des capacités de modélisation en ligne de Pentaho, qui permettent désormais d’obtenir de nouvelles métriques métier et de les partager entre utilisateurs.

· Nouvelles améliorations du service de données, qui permettent aux utilisateurs de créer des jeux de données virtuels sur un ensemble plus large de données croisées et de publier et modéliser automatiquement des données analytiques sans recourir à une table physique.

« Dans cette dernière version, Pentaho simplifie le transfert des données entre les différentes phases du pipeline des données analytiques, notamment l’intégration, l’ingénierie, la préparation et l’analyse des données. » explique Donna Prlich, Vice-présidente des solutions et du marketing produit chez Pentaho, société du groupe Hitachi. « Nous continuons à résoudre ces problèmes particulièrement difficiles associés aux Big Data, en offrant les meilleures performances possibles à tous les acteurs du pipeline de données. »

Outre les nouvelles fonctionnalités de la version 6.1, Pentaho a créé un nouveau projet type d’intégration des données en libre-service. Ce nouveau processus structuré permet aux clients et utilisateurs métier d’intégrer eux-mêmes une grande variété de données sans aucune aide de l’équipe informatique, ce qui simplifie le processus d’ingestion des données. La fonctionnalité d’injection de métadonnées de Pentaho est au cœur de ce dernier projet type de Pentaho.

Un client de Pentaho, Kingland Systems, fournit des applications de gestion des données dédiées au secteur de la finance. Selon Matt Good, directeur de l’Architecture logicielle, Kingland Systems, « Pentaho permet à notre solution de simplifier le processus d’intégration des données pour nos clients, leur permettant ainsi d’intégrer des données de différents systèmes et formats dans notre solution. La suppression des goulots d’étranglement inhérents à l’intégration manuelle des données a grandement contribué au succès de notre solution, offrant une rapidité et un niveau de précision qui satisfont les besoins en matière de gestion et d’analyse des données de nos clients. »

Meilleures agilité, collaboration et flexibilité pour des analyses des Big Data plus performantes

Les nouvelles fonctionnalités de la plateforme d’intégration et d’analyse des données Pentaho 6.1 aident les entreprises à configurer leurs pipelines de données pour prendre en charge un volume, une variété et une complexité des données toujours plus importants. Les principales nouvelles caractéristiques sont les suivantes :

· Améliorations des capacités de modélisation en ligne de Pentaho, qui permettent désormais d’obtenir de nouvelles métriques métier et de les partager entre utilisateurs.

· Nouvelles améliorations du service de données, qui permettent aux utilisateurs de créer des jeux de données virtuels sur un ensemble plus large de données croisées et de publier et modéliser automatiquement des données analytiques sans recourir à une table physique.

« Dans cette dernière version, Pentaho simplifie le transfert des données entre les différentes phases du pipeline des données analytiques, notamment l’intégration, l’ingénierie, la préparation et l’analyse des données. » explique Donna Prlich, Vice-présidente des solutions et du marketing produit chez Pentaho, société du groupe Hitachi. « Nous continuons à résoudre ces problèmes particulièrement difficiles associés aux Big Data, en offrant les meilleures performances possibles à tous les acteurs du pipeline de données. »

Autres articles

-

Hitachi Vantara annonce Pentaho 8.0 incluant le traitement des données en temps réel pour accélérer l’accès des entreprises à des informations approfondies

-

Pentaho annonce 134% de croissance annuelle de ses commandes IoT

-

Pentaho étend Spark à toute l’entreprise

-

Que se passera-t-il en 2017 ? Préparez-vous à l’inattendu !

-

Pentaho 7.0 comble l’écart de données entre les métiers et le service informatique