Benoit CAYLA, Consultant avant-vente, Informatica France

Heureusement les choses ont bien changées depuis.

La qualité de données, si ce n'est pas un sujet récent - du moins techniquement - est aujourd'hui, on peut le dire, un sujet mature qui entre au cœur des préoccupations de tous. Oui tous, car cette prise de conscience transparait tant du côté de l'IT (ou de la Maîtrise d'œuvre) que des métiers (ou Maîtrise d'ouvrage).

Prise de conscience, certes mais ... Pourquoi ?

Et bien j'y vois plusieurs raison à cela. La première peut-être est que la vague initiale de déploiement des progiciels (particulièrement les ERP) est dorénavant terminée. Tous les SI - ou presque - en possède un ! Mais ces ERP qui devaient faire converger et unifier les informations de l'entreprise, ont-ils été à la hauteur des ambitions qui pesaient sur eux ? ont-ils répondus aux attentes des utilisateurs ? Une chose est sûre : les besoins en termes d'intégration n'ont cessés de croître depuis, et continuent à croître encore. Ces progiciels sont en outre bien souvent trop fermés et peu performant vis-à-vis de l’extérieur. De plus tout nouveau déploiement représente souvent un coût prohibitif : d’où l’apparition de nombreuses applications satellites. En d'autre terme l'unification de la gestion des informations via l'utilisation des ERP n'est sans doute pas à la hauteur de ses ambitions passées !

La seconde raison est une conséquence du nombre incroyable de fusions et acquisitions des entreprises qui a eu lieu ces dernières années. En effet ces changements organisationnels ont eu un impact direct sur les SI et il a donc fallu songer à Décommissionner, Archiver et bien sûr Migrer un nombre colossal d'applications et donc de données. Or bien souvent ces démarches ont été réalisées de manière artisanales et par conséquence hasardeuses : d'où l'insertion de données inutilisables, inappropriées ou pire erronées dans les nouveaux systèmes.

La troisième et dernière raison que j'évoquerai ici, et qui est aussi un facteur aggravant de la détérioration des données, est due à l'augmentation considérable et exponentielle des volumes d'informations dans les systèmes informatiques. C'est ce que l'on nomme aujourd'hui le phénomène de "Big Data" qui, s’il ne touche pas encore toutes les entreprises ne va certainement pas tarder à se manifester. Les données qu'elles soient structurées ou non doivent en effet être stockées à tout prix et bien souvent sous n'importe quel format, elles doivent être présentes dans le SI ... pour ... ? Mais pourquoi ? À quoi cela sert-il si elles ne sont pas exploitables ? Voilà un enjeu de taille pour les entreprise qui voudront exploiter réellement leurs données, et pourquoi pas celles issues du monde extérieur (comme les partenaires, les médias et réseaux sociaux, etc...).

La qualité de données, si ce n'est pas un sujet récent - du moins techniquement - est aujourd'hui, on peut le dire, un sujet mature qui entre au cœur des préoccupations de tous. Oui tous, car cette prise de conscience transparait tant du côté de l'IT (ou de la Maîtrise d'œuvre) que des métiers (ou Maîtrise d'ouvrage).

Prise de conscience, certes mais ... Pourquoi ?

Et bien j'y vois plusieurs raison à cela. La première peut-être est que la vague initiale de déploiement des progiciels (particulièrement les ERP) est dorénavant terminée. Tous les SI - ou presque - en possède un ! Mais ces ERP qui devaient faire converger et unifier les informations de l'entreprise, ont-ils été à la hauteur des ambitions qui pesaient sur eux ? ont-ils répondus aux attentes des utilisateurs ? Une chose est sûre : les besoins en termes d'intégration n'ont cessés de croître depuis, et continuent à croître encore. Ces progiciels sont en outre bien souvent trop fermés et peu performant vis-à-vis de l’extérieur. De plus tout nouveau déploiement représente souvent un coût prohibitif : d’où l’apparition de nombreuses applications satellites. En d'autre terme l'unification de la gestion des informations via l'utilisation des ERP n'est sans doute pas à la hauteur de ses ambitions passées !

La seconde raison est une conséquence du nombre incroyable de fusions et acquisitions des entreprises qui a eu lieu ces dernières années. En effet ces changements organisationnels ont eu un impact direct sur les SI et il a donc fallu songer à Décommissionner, Archiver et bien sûr Migrer un nombre colossal d'applications et donc de données. Or bien souvent ces démarches ont été réalisées de manière artisanales et par conséquence hasardeuses : d'où l'insertion de données inutilisables, inappropriées ou pire erronées dans les nouveaux systèmes.

La troisième et dernière raison que j'évoquerai ici, et qui est aussi un facteur aggravant de la détérioration des données, est due à l'augmentation considérable et exponentielle des volumes d'informations dans les systèmes informatiques. C'est ce que l'on nomme aujourd'hui le phénomène de "Big Data" qui, s’il ne touche pas encore toutes les entreprises ne va certainement pas tarder à se manifester. Les données qu'elles soient structurées ou non doivent en effet être stockées à tout prix et bien souvent sous n'importe quel format, elles doivent être présentes dans le SI ... pour ... ? Mais pourquoi ? À quoi cela sert-il si elles ne sont pas exploitables ? Voilà un enjeu de taille pour les entreprise qui voudront exploiter réellement leurs données, et pourquoi pas celles issues du monde extérieur (comme les partenaires, les médias et réseaux sociaux, etc...).

Si elles ne sont pas les seules - ce n'est bien sûr pas un constat exhaustif - voilà en tout cas trois bonnes raison de se soucier de la qualité des données qui sont entreposées dans le SI.

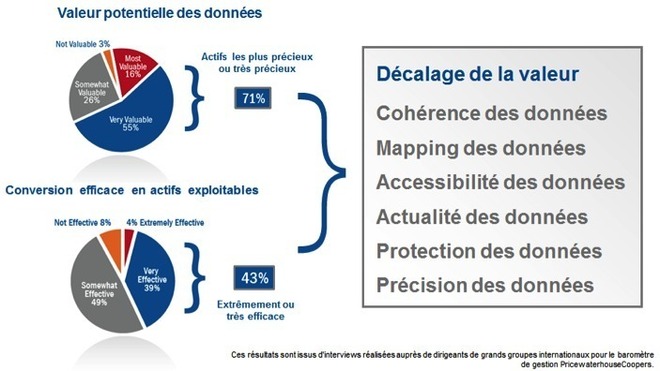

Le débat sur la qualité est désormais passé, il importe désormais de gérer ses données, de les redresser et surtout de s'assurer qu'elles restent de bonne qualité. De même le choix d'une démarche outillée n'a plus à faire ses preuves si elle veut - et le doit ! - s'inscrire dans la durée. Les enjeux sont donc aujourd'hui sur la manière, la méthode et surtout la pérennité d'une telle démarche. Car un projet de qualité de données est un projet qui fait peur, et il fait peur car bien souvent les intervenants ne sont pas outillés pour maîtriser cette part « incontrôlable » des données que l’on va devoir redresser. Cela explique sans doute le résultat d’un sondage de PricewaterhouseCoopers (PwC) qui déclare que « 90 % des entreprises jugent indispensable d’avoir une stratégie de qualité de données, mais seules 15 % l’adressent vraiment ».

Il n'y a donc pas 40 façons de mener à bien un projet de qualité de données.

Pour bien réussir ce type de projet il faut tout d’abord bien appréhender ses caractéristiques particulières : un projet de qualité de données n’est pas un projet « ordinaire ». Tout d'abord ce dernier doit parfaitement s'intégrer dans la stratégie IT de l'entreprise. Toute démarche ponctuelle, si elle n'est pas vouée à l'échec au démarrage, ne pourra s'inscrire dans le temps, et devra donc être remise en cause ultérieurement. Deuxièmement, un projet de qualité de données ne s'arrête pas au déploiement, il doit au contraire sans arrêt se réajuster selon les différents aléas qui vont modifier les données sources. C’est donc intrinsèquement un projet itératif qui doit être flexible et réactif à toute nouvelle demande ou modification afin de pouvoir rapidement prendre en compte de nouvelles règles de redressement (découvertes bien après le déploiement). Pour finir (et ce n’est pas le critère le moins important), un projet de qualité de données doit être vu comme un sous-projet d'un projet d'ensemble : Business Intelligence, Migration, Mise à jour progiciel, etc… qui lui-même est inscrit dans le schéma directeur de l'entreprise.

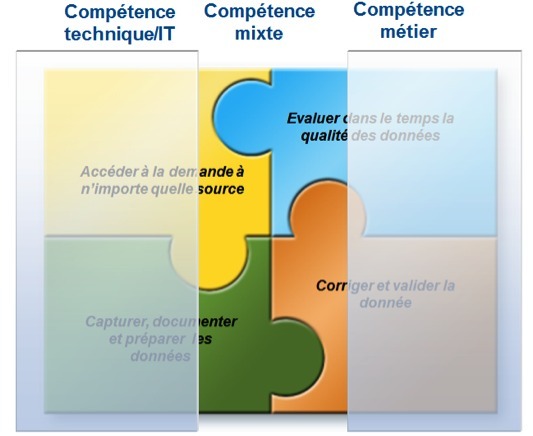

Pour conclure, un projet de qualité de données est avant tout un projet de la Maîtrise d'ouvrage ! Ce type de projet - s’il doit être "contrôlé" par la MOE - ne peut en effet réussir sans une grande implication des personnes qui connaissent la réelle signification des informations. La DSI ou la MOE ne peut donc pas mener seule un projet tel que celui-ci ! Certains me diront qu'avec un bon dossier de spécifications tout devrait bien se passer. Et bien avec de la chance peut-être ! En tout cas, cela serait sans prendre en compte la dimension changeante et parfois même "aléatoire" des données que l'on va traiter. Car traiter des données, c'est traiter de l'information; et l'information n'a du sens que pour ceux qui la connaisse ! Tenez ... si vous parlez à peine Anglais, vous pourrez toujours lire un livre, mais serez-vous à même d'en corriger les fautes ? Il faut donc laisser la main à ceux qui connaissent les données, et leur donner le plus de capacité d’intervention dans le projet.

Le débat sur la qualité est désormais passé, il importe désormais de gérer ses données, de les redresser et surtout de s'assurer qu'elles restent de bonne qualité. De même le choix d'une démarche outillée n'a plus à faire ses preuves si elle veut - et le doit ! - s'inscrire dans la durée. Les enjeux sont donc aujourd'hui sur la manière, la méthode et surtout la pérennité d'une telle démarche. Car un projet de qualité de données est un projet qui fait peur, et il fait peur car bien souvent les intervenants ne sont pas outillés pour maîtriser cette part « incontrôlable » des données que l’on va devoir redresser. Cela explique sans doute le résultat d’un sondage de PricewaterhouseCoopers (PwC) qui déclare que « 90 % des entreprises jugent indispensable d’avoir une stratégie de qualité de données, mais seules 15 % l’adressent vraiment ».

Il n'y a donc pas 40 façons de mener à bien un projet de qualité de données.

Pour bien réussir ce type de projet il faut tout d’abord bien appréhender ses caractéristiques particulières : un projet de qualité de données n’est pas un projet « ordinaire ». Tout d'abord ce dernier doit parfaitement s'intégrer dans la stratégie IT de l'entreprise. Toute démarche ponctuelle, si elle n'est pas vouée à l'échec au démarrage, ne pourra s'inscrire dans le temps, et devra donc être remise en cause ultérieurement. Deuxièmement, un projet de qualité de données ne s'arrête pas au déploiement, il doit au contraire sans arrêt se réajuster selon les différents aléas qui vont modifier les données sources. C’est donc intrinsèquement un projet itératif qui doit être flexible et réactif à toute nouvelle demande ou modification afin de pouvoir rapidement prendre en compte de nouvelles règles de redressement (découvertes bien après le déploiement). Pour finir (et ce n’est pas le critère le moins important), un projet de qualité de données doit être vu comme un sous-projet d'un projet d'ensemble : Business Intelligence, Migration, Mise à jour progiciel, etc… qui lui-même est inscrit dans le schéma directeur de l'entreprise.

Pour conclure, un projet de qualité de données est avant tout un projet de la Maîtrise d'ouvrage ! Ce type de projet - s’il doit être "contrôlé" par la MOE - ne peut en effet réussir sans une grande implication des personnes qui connaissent la réelle signification des informations. La DSI ou la MOE ne peut donc pas mener seule un projet tel que celui-ci ! Certains me diront qu'avec un bon dossier de spécifications tout devrait bien se passer. Et bien avec de la chance peut-être ! En tout cas, cela serait sans prendre en compte la dimension changeante et parfois même "aléatoire" des données que l'on va traiter. Car traiter des données, c'est traiter de l'information; et l'information n'a du sens que pour ceux qui la connaisse ! Tenez ... si vous parlez à peine Anglais, vous pourrez toujours lire un livre, mais serez-vous à même d'en corriger les fautes ? Il faut donc laisser la main à ceux qui connaissent les données, et leur donner le plus de capacité d’intervention dans le projet.

Voilà pourquoi la collaboration MOE/MOA est si fondamentale dans ce type de projet. C'est pourquoi la solution Informatica Data Quality a pris cette orientation de fournir un maximum d'interactivités et de possibilités aux interlocuteurs métier. Avec Informatica Data Quality les MOA deviennent un acteur incontournable du projet de qualité de données, de sa mise en place jusqu'au suivi temporel (via des tableaux de bords). Grâce à une interface client léger simple d'utilisation (sans compétence technique requise), ils peuvent désormais analyser les données, les manipuler en direct, mettre en place des indicateurs et tableaux de bords et gérer des tables de référence.

Mais ce n'est pas tout, le processus de traitement/qualité des données n'étant bien souvent pas un processus entièrement automatisable, il est important d'y ajouter des interventions humaines pour un certain nombre d'actions et à certains moments. Informatica Data Quality permet aussi l'implication des MOA lors des phases de redressement d'informations (gestion des rejets, recyclage) mais permet aussi l'arbitrage manuel lors de la détection préalable (en logique floue) de potentiels doublons.

Pour résumer Informatica Data Quality n'est plus seulement un outil de développement pour la qualité de données, il est surtout une plate-forme collaborative IT/Métiers qui permet à tous les intervenants (métiers et développeurs) d'un projet de qualité de données de travailler de concert.

Mais ce n'est pas tout, le processus de traitement/qualité des données n'étant bien souvent pas un processus entièrement automatisable, il est important d'y ajouter des interventions humaines pour un certain nombre d'actions et à certains moments. Informatica Data Quality permet aussi l'implication des MOA lors des phases de redressement d'informations (gestion des rejets, recyclage) mais permet aussi l'arbitrage manuel lors de la détection préalable (en logique floue) de potentiels doublons.

Pour résumer Informatica Data Quality n'est plus seulement un outil de développement pour la qualité de données, il est surtout une plate-forme collaborative IT/Métiers qui permet à tous les intervenants (métiers et développeurs) d'un projet de qualité de données de travailler de concert.

Autres articles

-

Informatica renforce son partenariat avec Databricks avec des fonctionnalités d’IA générative natives pour la plateforme de Data Intelligence de Databricks

-

Informatica ouvre les portes de la gouvernance de données native dans le Cloud, alimentée par l'IA, aux clients de Google Cloud dans le cadre d'un partenariat élargi

-

Les cinq tendances majeures qui guideront les entreprises dans leur quête de transformation et d’innovation grâce à l’IA

-

Informatica annonce un vaste programme d'innovations pour les solutions d'analyse et d’IA générative, basé sur AWS

-

Informatica apporte sa contribution aux mégatendances de Microsoft Azure (IA générative, Microsoft Fabric et format en tables de données ouvertes) avec de nouvelles fonctionnalités