Il y a quelques semaines, je vous présentais les ingrédients qui constituaient de «bonnes» recettes ETL, ESB et leur couplage…

J’aimerais vous parler aujourd’hui d’un sujet vaste mais essentiel qui se retrouve très régulièrement, pour ne pas dire systématiquement, au cœur des problématiques d’entreprises: la qualité de données, communément appelée sous l’angle gestion dans sa version «anglophonisée» DQM (Data Quality Management).

Dans la continuité, nous pourrions rester sur une thématique gastronomique et apparenter la DQM à la sauce contribuant à une bonne recette. Partons là-dessus!

Qu’est-ce que la qualité de données au juste ?

Nous faisons de la Qualité de données depuis de nombreuses années, d’ailleurs, sans forcément toujours le savoir, à travers la BI dite «traditionnelle» ou de manière spécifique sur des initiatives plus ciblées, comme par exemple sur:

- Du redressement et de l’enrichissement de référentiels;

- Du contrôle qualité à la source des applications et/ou dans le suivi du cycle de vie des données;

- De la gouvernance de données;

- Des initiatives MDM;

- Des initiatives liées à la non-conformité des données (domaine réglementaire);

- Des cas de fusions-acquisitions;

- De la détection de fraude;

- De la migration de données.

Avec la massification des données et des flux d’échanges, le sujet est devenu de plus en plus omniprésent, crucial et complexe pour les entreprises et se pose aujourd’hui comme un vrai sujet stratégique.

Le Gartner indiquait d’ailleurs en 2017 que 33% des sociétés figurant au classement Fortune 100 seraient confrontées à une crise des informations en raison de leur incapacité à évaluer leurs informations et à en assurer la gouvernance et la fiabilité. Cela s’est vérifié dans de nombreux cas!

Commençons par définir ce que serait une sauce au sens «qualité de données» et de quoi doit-elle être constituée pour qu’elle soit réussie.

Dans sa définition conceptuelle c’est un ensemble de méthodes, de processus associés à une volonté et une responsabilité collective (métiers et IT) dans l’objectif d’analyser, de redresser et de suivre l’amélioration continue des données.

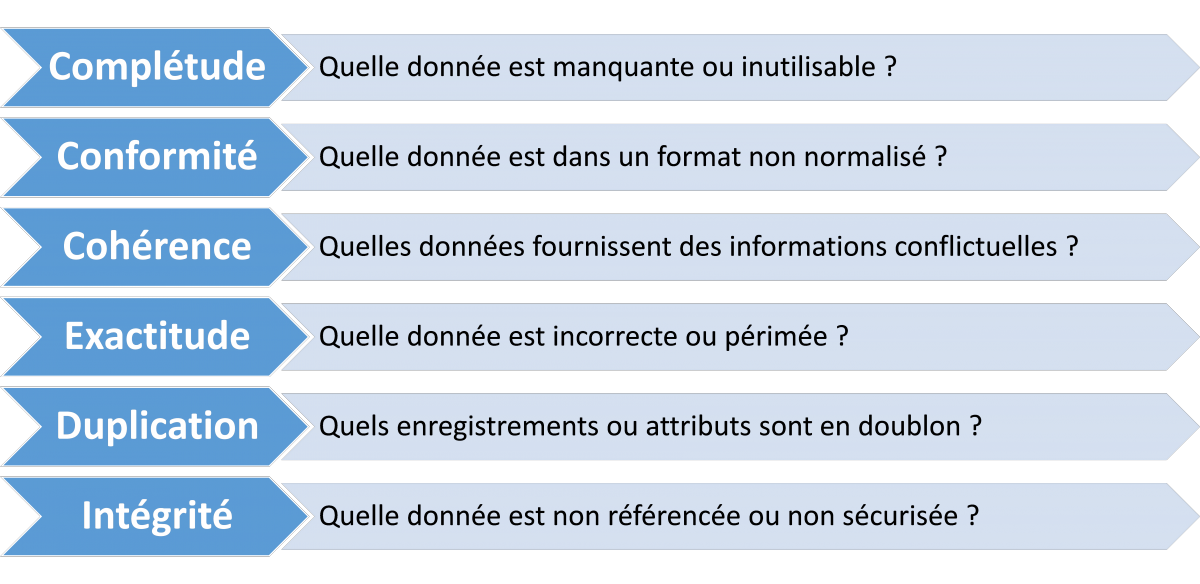

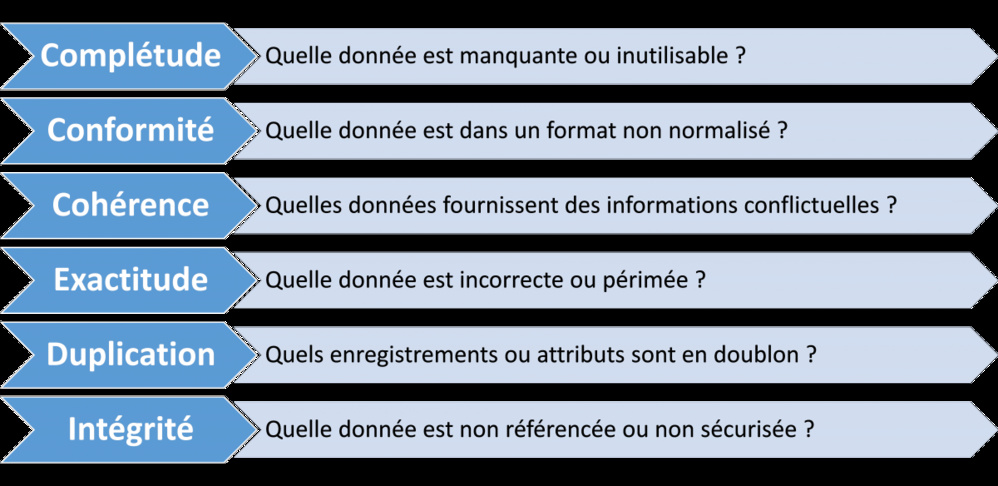

Une donnée de «bonne qualité» doit être:

- Définie et connue;

- Contrôlée dans le temps;

- Complète, Cohérente, Conforme, Intègre, Exacte;

- Unique;

- Certifiée quel que soit sa nature d’origine (format & type).

J’aimerais vous parler aujourd’hui d’un sujet vaste mais essentiel qui se retrouve très régulièrement, pour ne pas dire systématiquement, au cœur des problématiques d’entreprises: la qualité de données, communément appelée sous l’angle gestion dans sa version «anglophonisée» DQM (Data Quality Management).

Dans la continuité, nous pourrions rester sur une thématique gastronomique et apparenter la DQM à la sauce contribuant à une bonne recette. Partons là-dessus!

Qu’est-ce que la qualité de données au juste ?

Nous faisons de la Qualité de données depuis de nombreuses années, d’ailleurs, sans forcément toujours le savoir, à travers la BI dite «traditionnelle» ou de manière spécifique sur des initiatives plus ciblées, comme par exemple sur:

- Du redressement et de l’enrichissement de référentiels;

- Du contrôle qualité à la source des applications et/ou dans le suivi du cycle de vie des données;

- De la gouvernance de données;

- Des initiatives MDM;

- Des initiatives liées à la non-conformité des données (domaine réglementaire);

- Des cas de fusions-acquisitions;

- De la détection de fraude;

- De la migration de données.

Avec la massification des données et des flux d’échanges, le sujet est devenu de plus en plus omniprésent, crucial et complexe pour les entreprises et se pose aujourd’hui comme un vrai sujet stratégique.

Le Gartner indiquait d’ailleurs en 2017 que 33% des sociétés figurant au classement Fortune 100 seraient confrontées à une crise des informations en raison de leur incapacité à évaluer leurs informations et à en assurer la gouvernance et la fiabilité. Cela s’est vérifié dans de nombreux cas!

Commençons par définir ce que serait une sauce au sens «qualité de données» et de quoi doit-elle être constituée pour qu’elle soit réussie.

Dans sa définition conceptuelle c’est un ensemble de méthodes, de processus associés à une volonté et une responsabilité collective (métiers et IT) dans l’objectif d’analyser, de redresser et de suivre l’amélioration continue des données.

Une donnée de «bonne qualité» doit être:

- Définie et connue;

- Contrôlée dans le temps;

- Complète, Cohérente, Conforme, Intègre, Exacte;

- Unique;

- Certifiée quel que soit sa nature d’origine (format & type).

Mais, comment s’y prend-on pour la faire ?

Finalement, comment mieux se faire un avis sur une sauce que de la goûter? Alors goutons là en l’analysant sous différents angles:

Vous remarquerez que cette analyse s’applique toujours de la même manière; cette dernière pourrait constituer la première étape d’une démarche «généralisable»:

1. On découvre, on analyse les données

2. On définit des objectifs, on établit des métriques et des rapports sur ce que l’on veut suivre

3. On définit, on conçoit des règles (ex. sur le nettoyage, la normalisation, le rapprochement, la consolidation des données...)

4. On intègre ces règles et on met à disposition les rapports pour mieux suivre l’évolution

5. On analyse les exceptions, on ajuste les règles et parfois les données elles-mêmes

6. On suit les évolutions par rapport aux objectifs fixés, toujours dans un souci d’amélioration continue…cette petite touche finale à la sauce qui la rend si redoutable!

Finalement, comment mieux se faire un avis sur une sauce que de la goûter? Alors goutons là en l’analysant sous différents angles:

Vous remarquerez que cette analyse s’applique toujours de la même manière; cette dernière pourrait constituer la première étape d’une démarche «généralisable»:

1. On découvre, on analyse les données

2. On définit des objectifs, on établit des métriques et des rapports sur ce que l’on veut suivre

3. On définit, on conçoit des règles (ex. sur le nettoyage, la normalisation, le rapprochement, la consolidation des données...)

4. On intègre ces règles et on met à disposition les rapports pour mieux suivre l’évolution

5. On analyse les exceptions, on ajuste les règles et parfois les données elles-mêmes

6. On suit les évolutions par rapport aux objectifs fixés, toujours dans un souci d’amélioration continue…cette petite touche finale à la sauce qui la rend si redoutable!

Deux mises en application avec VISEO

Voici deux exemples d’entreprises dans des secteurs et contextes différents qui ont été amenés à mettre en application cette démarche avec l’accompagnement de VISEO:

1. Un grand industriel qui a été confronté à une vraie problématique de Qualité de données au sein de ses référentiels «articles» en particulier au niveau d’une information: la description de l’article (libellé long). Il doit impérativement le fiabiliser et l’enrichir au niveau des «données structurées» pour pouvoir afficher un libellé normalisé sur le web.

Cette information est stratégique pour l’entreprise tant en termes e-business que d’image.

2. Un acteur important dans le monde de l’assurance base la gestion de son portefeuille de clients (et de contrats actifs) et sa valorisation sur ses référentiels internes. Or, après audit de la qualité de ses référentiels, une série de dysfonctionnements a été identifiée et notamment la détection de 10% de ses clients en doublons. Cette démarche a été initiée suite à une directive réglementaire dans le but d’assurer la conformité des données au regard des usages prévus.

Ce sont des impacts financiers non négligeables pour l’entreprise qu’il a fallu gérer expressément pour corriger, puis préparer l’avenir.

A la lecture de ces deux exemples que nous pourrions étendre à d’autres cas d’entreprises, nous nous imaginons bien qu’il vaut mieux prévenir que guérir en déroulant l’élaboration d’une sauce de façon méthodique «pas à pas» avec tout le sérieux qui s’impose et en s’y prenant bien à l’avance!

Sachez qu’il existe des solutions éditeurs qui s’inscrivent complètement dans cette démarche de mise en qualité des données et qui ont fait leurs preuves tels que des acteurs comme Talend ou Informatica.

Voici deux exemples d’entreprises dans des secteurs et contextes différents qui ont été amenés à mettre en application cette démarche avec l’accompagnement de VISEO:

1. Un grand industriel qui a été confronté à une vraie problématique de Qualité de données au sein de ses référentiels «articles» en particulier au niveau d’une information: la description de l’article (libellé long). Il doit impérativement le fiabiliser et l’enrichir au niveau des «données structurées» pour pouvoir afficher un libellé normalisé sur le web.

Cette information est stratégique pour l’entreprise tant en termes e-business que d’image.

2. Un acteur important dans le monde de l’assurance base la gestion de son portefeuille de clients (et de contrats actifs) et sa valorisation sur ses référentiels internes. Or, après audit de la qualité de ses référentiels, une série de dysfonctionnements a été identifiée et notamment la détection de 10% de ses clients en doublons. Cette démarche a été initiée suite à une directive réglementaire dans le but d’assurer la conformité des données au regard des usages prévus.

Ce sont des impacts financiers non négligeables pour l’entreprise qu’il a fallu gérer expressément pour corriger, puis préparer l’avenir.

A la lecture de ces deux exemples que nous pourrions étendre à d’autres cas d’entreprises, nous nous imaginons bien qu’il vaut mieux prévenir que guérir en déroulant l’élaboration d’une sauce de façon méthodique «pas à pas» avec tout le sérieux qui s’impose et en s’y prenant bien à l’avance!

Sachez qu’il existe des solutions éditeurs qui s’inscrivent complètement dans cette démarche de mise en qualité des données et qui ont fait leurs preuves tels que des acteurs comme Talend ou Informatica.

Autres articles

-

Boomi et VISEO officialisent leur partenariat pour accompagner les entreprises dans leurs projets stratégiques de Data Management

-

VISEO se dote de l’expertise de Sidetrade comme puissant levier de transformation et d’innovation

-

Repenser le prototypage de vos solutions avec SAP Build

-

Les dessous d’un projet de Data Science

-

Business Intelligence et Data : 6 tendances clés