Jean-François VANNIER, Responsable commercial Infrastructure décisionnelles BULL France

A l’heure où l’on cherche donc à banaliser, à standardiser, à virtualiser les infrastructures informatiques, utiliser des infrastructures spécifiques pour adresser telle ou telle problématique de l’entreprise semble aller à l’encontre de ce mouvement. D’autant plus que les premiers retours concrets d’expérience montrent que la virtualisation fonctionne et est capable d’adresser un grand nombre de cas d’usages du Système d’information.

Néanmoins, la généralisation de ces technologies se heurte parfois à des limites : limites physiques liées aux distances, aux débits réseau disponibles; limites économiques du fait du coût du portage de l’existant vers ses architectures cibles ; limites dans les capacités fonctionnelles de ces composants : certains conçus pour la performance, d’autres pour la sécurité, d’autres encore pour la capacité de stockage…. Et il est souvent difficile de sortir de ces cadres d’usage.

Le cadre d’usage Décisionnel.

Un système décisionnel doit être capable de présenter une vision générale de l’entreprise de multiples façons en fonction des besoins et des interrogations. Si les SGBD de production sont avant tout des systèmes transactionnels destinés à gérer l’activité de l’entreprise, le Data Warehouse est, lui, avant tout, un système d’interrogation. Il collecte, combine, trie, filtre, réorganise, relie et remodèle les informations provenant des multiples systèmes et sources de données de l’entreprise. Il offre un accès à une très vaste quantité d’informations afin de répondre au plus grand nombre de questions possibles. L’information doit y être donc stockée de sorte à satisfaire ces besoins efficacement.

Les applications décisionnelles s’appuient généralement sur des Data warehouses volumineux, comprenant des données récentes détaillées et historiques. Elles effectuent des requêtes de lecture par des contraintes de performance parfois contradictoires avec les volumes traités. Elles mixent des requêtes planifiées et avec des requêtes inopinées établies par l’utilisateur en fonction des besoins du moment.

Et ces utilisateurs demandent de la performance…ou plus précisément de la linéarité et de la régularité dans les performances. « Si ma requête met 1 seconde pour 1 an d’historique, pourquoi met-elle 51minute sur 2 années….Et pourquoi met-elle met 5 fois plus de temps à 8h30 quand je suis tout seul qu’à 16h…. »

Conséquences pour les infrastructures

De ce fait, le choix d’une architecture pour héberger le Data Warehouse est une étape complexe. Elle consiste en réalité à résoudre une équation à quatre inconnues: la volumétrie des données, le nombre d’utilisateurs (et par voie de conséquence le nombre de requêtes simultanées), la complexité des requêtes et la complexité du modèle logique des données (3ème forme normale, flocon, étoile, dimensionnel, multidimensionnel) ; deux de ces inconnues sont liées au métier de l’entreprise – les requêtes et les modèles -, les deux autres sont des données quantitatives – le volume de données et le nombre d’utilisateurs.

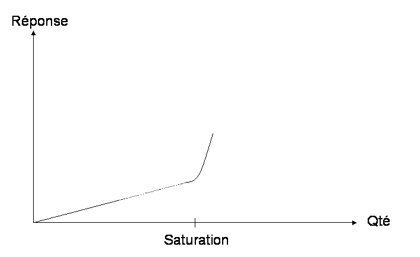

Pour concevoir un Data Warehouse qui garantit la linéarité des performances les architectes vont chercher à repousser le moment où le système va saturer et entraîner des délais de réponses inacceptable par les utilisateurs.

Néanmoins, la généralisation de ces technologies se heurte parfois à des limites : limites physiques liées aux distances, aux débits réseau disponibles; limites économiques du fait du coût du portage de l’existant vers ses architectures cibles ; limites dans les capacités fonctionnelles de ces composants : certains conçus pour la performance, d’autres pour la sécurité, d’autres encore pour la capacité de stockage…. Et il est souvent difficile de sortir de ces cadres d’usage.

Le cadre d’usage Décisionnel.

Un système décisionnel doit être capable de présenter une vision générale de l’entreprise de multiples façons en fonction des besoins et des interrogations. Si les SGBD de production sont avant tout des systèmes transactionnels destinés à gérer l’activité de l’entreprise, le Data Warehouse est, lui, avant tout, un système d’interrogation. Il collecte, combine, trie, filtre, réorganise, relie et remodèle les informations provenant des multiples systèmes et sources de données de l’entreprise. Il offre un accès à une très vaste quantité d’informations afin de répondre au plus grand nombre de questions possibles. L’information doit y être donc stockée de sorte à satisfaire ces besoins efficacement.

Les applications décisionnelles s’appuient généralement sur des Data warehouses volumineux, comprenant des données récentes détaillées et historiques. Elles effectuent des requêtes de lecture par des contraintes de performance parfois contradictoires avec les volumes traités. Elles mixent des requêtes planifiées et avec des requêtes inopinées établies par l’utilisateur en fonction des besoins du moment.

Et ces utilisateurs demandent de la performance…ou plus précisément de la linéarité et de la régularité dans les performances. « Si ma requête met 1 seconde pour 1 an d’historique, pourquoi met-elle 51minute sur 2 années….Et pourquoi met-elle met 5 fois plus de temps à 8h30 quand je suis tout seul qu’à 16h…. »

Conséquences pour les infrastructures

De ce fait, le choix d’une architecture pour héberger le Data Warehouse est une étape complexe. Elle consiste en réalité à résoudre une équation à quatre inconnues: la volumétrie des données, le nombre d’utilisateurs (et par voie de conséquence le nombre de requêtes simultanées), la complexité des requêtes et la complexité du modèle logique des données (3ème forme normale, flocon, étoile, dimensionnel, multidimensionnel) ; deux de ces inconnues sont liées au métier de l’entreprise – les requêtes et les modèles -, les deux autres sont des données quantitatives – le volume de données et le nombre d’utilisateurs.

Pour concevoir un Data Warehouse qui garantit la linéarité des performances les architectes vont chercher à repousser le moment où le système va saturer et entraîner des délais de réponses inacceptable par les utilisateurs.

Repousser ce point de saturation suppose soit sur l’optimisation du fonctionnel – Modèle de données et requêtes – ce qui demande des investissements humains, soit de concevoir une infrastructure qui traite efficacement les paramètres quantitatifs de volumétrie et de concurrence d’accès. C’est ce dernier point qu’adressent les appliances décisionnelles.

Les appliances décisionnelles : Le matériel au service du logiciel

Les appliances décisionnelles sont des solutions conçues pour assurer une utilisation optimale des possibilités des ressources matérielles disponibles ainsi qu’un contrôle complet de ces ressources. Elles sont basées sur une imbrication fine du logiciel et du matériel pour assurer au mieux le service recherché dans le cadre décisionnel – Parallélisme des traitements, gestion des flux, etc. La capacité de traitement de l’information est connue et maîtrisée, limitant fortement la mauvaise surprise d’un lien réseau occupé par un téléchargement, d’un contrôleur disque utilisé par une mise à jour aussi volumineuse qu’inattendue, etc.

C’est donc la spécialisation de cette architecture combinée de matériel et de logiciel qui permet d’obtenir et de garantir la performance, de repousser loin le point de saturation de la plate-forme.

Au-delà de la performance

Les Appliances décisionnelles vont ainsi pouvoir fournir des performances impossibles à obtenir par un autre biais. Elles sont une solution incontournable pour les consommateurs de « grands » datawarehouses – Banques, Telecom, Distribution, Internet…

Du fait de leur gestion optimale des ressources, elles vont également proposer un service de qualité à un prix très compétitif pour des systèmes décisionnels moins « haut de gamme ». Ce positionnement économique est d’autant plus avéré que la plupart des solutions du marché s’intègrent facilement dans les outils et procédures d’exploitation des systèmes d’information.

L’Appliance Décisionnelle peut ainsi devenir la brique élémentaire du mouvement de démocratisation du décisionnel que la plupart des entreprises appellent de leurs vœux ; une brique spécifique, spécialisée mais cohérente avec les nouvelles architectures de Système d’information.

Les appliances décisionnelles : Le matériel au service du logiciel

Les appliances décisionnelles sont des solutions conçues pour assurer une utilisation optimale des possibilités des ressources matérielles disponibles ainsi qu’un contrôle complet de ces ressources. Elles sont basées sur une imbrication fine du logiciel et du matériel pour assurer au mieux le service recherché dans le cadre décisionnel – Parallélisme des traitements, gestion des flux, etc. La capacité de traitement de l’information est connue et maîtrisée, limitant fortement la mauvaise surprise d’un lien réseau occupé par un téléchargement, d’un contrôleur disque utilisé par une mise à jour aussi volumineuse qu’inattendue, etc.

C’est donc la spécialisation de cette architecture combinée de matériel et de logiciel qui permet d’obtenir et de garantir la performance, de repousser loin le point de saturation de la plate-forme.

Au-delà de la performance

Les Appliances décisionnelles vont ainsi pouvoir fournir des performances impossibles à obtenir par un autre biais. Elles sont une solution incontournable pour les consommateurs de « grands » datawarehouses – Banques, Telecom, Distribution, Internet…

Du fait de leur gestion optimale des ressources, elles vont également proposer un service de qualité à un prix très compétitif pour des systèmes décisionnels moins « haut de gamme ». Ce positionnement économique est d’autant plus avéré que la plupart des solutions du marché s’intègrent facilement dans les outils et procédures d’exploitation des systèmes d’information.

L’Appliance Décisionnelle peut ainsi devenir la brique élémentaire du mouvement de démocratisation du décisionnel que la plupart des entreprises appellent de leurs vœux ; une brique spécifique, spécialisée mais cohérente avec les nouvelles architectures de Système d’information.

Autres articles

-

BullSequana S800 devient mondialement le serveur le plus performant du marché pour SAP HANA avec un résultat inégalé

-

Le CEA acquiert un supercalculateur BullSequana d’Atos équipé de processeurs Marvell ThunderX2 basés sur une architecture Arm

-

L’institut de recherche britannique de Pirbright s’équipe d’un supercalculateur Atos afin de lutter contre les maladies virales animales et humaines

-

Atos obtient la certification SAP HANA® pour son serveur bullion permettant d’opérer jusqu’à 16 Téraoctets de données

-

Atos booste la recherche néerlandaise avec son supercalculateur Bull sequana installé chez SURFsara