Bientôt la fin du Big Data ?

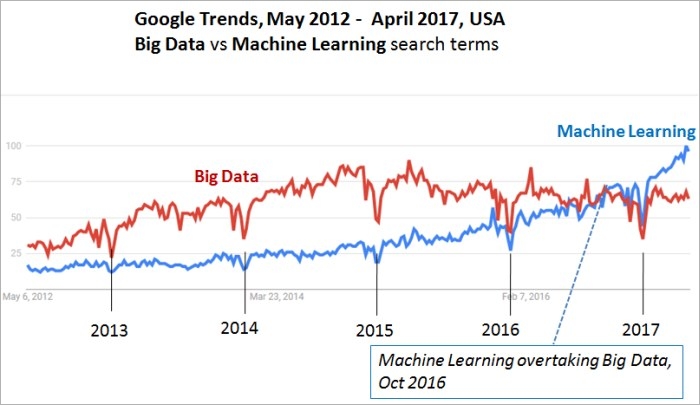

Un graphique intéressant a été publié sur kdnuggets la semaine passée. Ce graphique montre les tendances de recherche des mots clés "Big Data" et "Machine Learning".

On y voit que les recherches Big Data affichent un plateau alors que celles relatives au Machine Learning sont en croissance exponentielle. D’autres mots clé (Deep learning, IA ... ) ainsi que les tendances monde donnent des évolutions similaires.

Serait-ce la fin du Big data ? Le Machine learning serait-il le nouvel hype des DSI ?

On y voit que les recherches Big Data affichent un plateau alors que celles relatives au Machine Learning sont en croissance exponentielle. D’autres mots clé (Deep learning, IA ... ) ainsi que les tendances monde donnent des évolutions similaires.

Serait-ce la fin du Big data ? Le Machine learning serait-il le nouvel hype des DSI ?

20 ans de centralisation des données

Pour y voir plus clair, nous pouvons dresser un parallèle avec ce qu’il s’est passé il y a 20 ans, au milieu des années 90. Par expertise je me limiterai au cas des données clients mais ce qui suit peut être largement généralisé à d’autres secteurs.

Le hype de l’époque s’appelait Base de données clients et Datawarehouse. Les entreprises se sont alors massivement lancées dans des POC puis des projets de construction de datawarehouse.

Ca ne vous rappelle pas quelque chose ? Remplacez Base de données clients et Datawarehouse par Big Data et Data Lake ...

Bien sûr les technologies sont différentes. Bien sûr les puissances de stockage et de traitement sont sans commune mesure. Néanmoins ces technologies s’inscrivent dans la même philosophie. Celle de centraliser et stocker les données. Le Big Data n’est que la composante la plus récente, en passe de devenir une technologie mainstream.

Le hype de l’époque s’appelait Base de données clients et Datawarehouse. Les entreprises se sont alors massivement lancées dans des POC puis des projets de construction de datawarehouse.

Ca ne vous rappelle pas quelque chose ? Remplacez Base de données clients et Datawarehouse par Big Data et Data Lake ...

Bien sûr les technologies sont différentes. Bien sûr les puissances de stockage et de traitement sont sans commune mesure. Néanmoins ces technologies s’inscrivent dans la même philosophie. Celle de centraliser et stocker les données. Le Big Data n’est que la composante la plus récente, en passe de devenir une technologie mainstream.

La centralisation des données au détriment de l’analytique

L’objectif des bases de données clients et des datawarehouses était, à l’époque, de mettre en place une vision client 360° pour améliorer la relation clients en utilisant les outils de (avec les mots de l’époque) segmentation clients, prédictif, machine learning.

Ce qui est particulièrement intéressant, c’est que si les mots (et les technologies) employés pour le stockage et le traitement ont changé, ce n’est pas le cas de ceux relatifs à l’utilisation intelligente de ces données : segmentation clients, prédictif, machine learning ...

Ceci n’est pas anodin car si les algorithmes ont progressé en sophistication et, un peu, en efficacité (rapportée au CPU disponible), leur philosophie et leur mise en œuvre sont restées essentiellement les mêmes. Si leur performance a bondi c’est principalement du côté de la croissance exponentielle de la puissance de calcul (merci Mr Moore) qu’il faut aller en chercher la raison. L’exemple peut être le plus frappant est évidemment le Deep learning qui n’est pas essentiellement différent des réseaux de neurones des années 90 si ce n’est le nombre de couches de traitement plus important qu’autorise le calcul intensif d’aujourd’hui.

A quoi a-t-on assisté au cours des deux décennies qui ont suivi l’introduction des datawarehouses ? Si la centralisation des données a été effective, elle a donné lieu en revanche à un usage largement limité à du factuel, reporting et tableaux de bord. L’usage intelligent et sophistiqué des données, tel qu’il avait été imaginé initialement, c’est à dire celui qui aurait permis de comprendre en profondeur et d’anticiper les comportements clients, a finalement été peu mis en œuvre et limité aux entreprises les plus consommatrices de données et plus encore ... aux plus importantes. Si on en doute il suffit de mettre en regard les 240M€ du marché de data mining estimé en France et les 140000 entreprises de 10 salariés et plus, ce qui fait moins de 2000€ par an et par entreprise !

Les raisons sont connues et tiennent essentiellement à la complexité inhérente à la démarche analytique. Une forte expertise est nécessaire, les coûts associés sont élevés, et prohibitifs pour une entreprise qui n’a pas la culture nécessaire pour apprécier pleinement la valeur de l’investissement.

Alors va-t-on assister à la poursuite de la course effrénée à la centralisation des données et leur stockage ? A une démarche qui fera encore fi d’un traitement intelligent des données? L’histoire analytique serait-elle un éternel recommencement ?

Ce qui est particulièrement intéressant, c’est que si les mots (et les technologies) employés pour le stockage et le traitement ont changé, ce n’est pas le cas de ceux relatifs à l’utilisation intelligente de ces données : segmentation clients, prédictif, machine learning ...

Ceci n’est pas anodin car si les algorithmes ont progressé en sophistication et, un peu, en efficacité (rapportée au CPU disponible), leur philosophie et leur mise en œuvre sont restées essentiellement les mêmes. Si leur performance a bondi c’est principalement du côté de la croissance exponentielle de la puissance de calcul (merci Mr Moore) qu’il faut aller en chercher la raison. L’exemple peut être le plus frappant est évidemment le Deep learning qui n’est pas essentiellement différent des réseaux de neurones des années 90 si ce n’est le nombre de couches de traitement plus important qu’autorise le calcul intensif d’aujourd’hui.

A quoi a-t-on assisté au cours des deux décennies qui ont suivi l’introduction des datawarehouses ? Si la centralisation des données a été effective, elle a donné lieu en revanche à un usage largement limité à du factuel, reporting et tableaux de bord. L’usage intelligent et sophistiqué des données, tel qu’il avait été imaginé initialement, c’est à dire celui qui aurait permis de comprendre en profondeur et d’anticiper les comportements clients, a finalement été peu mis en œuvre et limité aux entreprises les plus consommatrices de données et plus encore ... aux plus importantes. Si on en doute il suffit de mettre en regard les 240M€ du marché de data mining estimé en France et les 140000 entreprises de 10 salariés et plus, ce qui fait moins de 2000€ par an et par entreprise !

Les raisons sont connues et tiennent essentiellement à la complexité inhérente à la démarche analytique. Une forte expertise est nécessaire, les coûts associés sont élevés, et prohibitifs pour une entreprise qui n’a pas la culture nécessaire pour apprécier pleinement la valeur de l’investissement.

Alors va-t-on assister à la poursuite de la course effrénée à la centralisation des données et leur stockage ? A une démarche qui fera encore fi d’un traitement intelligent des données? L’histoire analytique serait-elle un éternel recommencement ?

La majorité des entreprises analytiquement illettrées

On observe qu’avec la diffusion des technologies Big data les entreprises sont encore plus enclines à appliquer le même raisonnement : “Avant d’analyser et d’utiliser mes données il est urgent de collecter, rassembler et stocker toutes les données en un même lieu. Après un inventaire précis je pourrais alors exploiter au mieux mes données”.

Cette démarche serait une erreur, la même que celle qui a conduit à passer 20 ans à stocker et organiser des données et a laissé la majorité des entreprises analytiquement illettrées.

D’une part il n’y a pas de limites à la diversité et au volume de données stockées aujourd’hui. Cette fuite en avant serait une course sans fin.

D’autre part, des données aussi classiques que, par exemple, les données d’achat ont une richesse analytique de premier plan qui permet des analyses sophistiquées opérationnelles. Nul besoin de téraoctets pour anticiper finement les comportements clients. Et dans la pratique, l’intelligence, la valeur ajoutée et l’information surprenante extraites d’1 To de données sont souvent bien inférieures à celles contenues dans 1 Go! Les entreprises n’ont nul besoin d’attendre d’hypothétiques téraoctets pour analyser intelligemment leurs données. Elles pourront simplement raffiner au fur et à mesure de leur disponibilité.

Cette démarche serait une erreur, la même que celle qui a conduit à passer 20 ans à stocker et organiser des données et a laissé la majorité des entreprises analytiquement illettrées.

D’une part il n’y a pas de limites à la diversité et au volume de données stockées aujourd’hui. Cette fuite en avant serait une course sans fin.

D’autre part, des données aussi classiques que, par exemple, les données d’achat ont une richesse analytique de premier plan qui permet des analyses sophistiquées opérationnelles. Nul besoin de téraoctets pour anticiper finement les comportements clients. Et dans la pratique, l’intelligence, la valeur ajoutée et l’information surprenante extraites d’1 To de données sont souvent bien inférieures à celles contenues dans 1 Go! Les entreprises n’ont nul besoin d’attendre d’hypothétiques téraoctets pour analyser intelligemment leurs données. Elles pourront simplement raffiner au fur et à mesure de leur disponibilité.

L’automatisation : passage obligé pour la data science

L’automatisation des tâches d’analyse est en outre en train de simplifier grandement la vie des utilisateurs. Comme tous les autres secteurs de l’activité humaine, la data science n’échappe en effet pas à cette tendance lourde qui consiste à automatiser tout ce qui est automatisable et, en premier lieu, les tâches répétitives et non créatives. Et que ce soit l’analyse des données marketing, journalistiques, financières ou juridiques il y en a des tonnes! Ici comme pour tous les autres pans de l’activité humaine, 80% des analyses de données seront bientôt réalisées sans intervention humaine, les tâches les plus pointues, les plus intelligentes, étant bien entendu réservées aux data scientists.

Il y a moins de 5 ans, data scientist était classé dans le top 10 des métiers les plus demandés de la décennie à venir. Aujourd’hui on est un peu revenu de cet engouement. Le data scientist expérimenté sera certainement important dans une entreprise, mais il semble de plus en plus évident qu’il y aura moins besoin d’une armée de data scientists que d’une équipe d’analystes métier capable de digérer et consommer (et non de réaliser) les analyses qui seront le plus souvent produites par les algorithmes automatisés. Ce qui est d’ailleurs une bonne nouvelle puisque, s’il est difficile de trouver un data scientist dans une entreprise du fait de sa rareté et de son coût, on trouve pléthore d’analystes métier talentueux qui sauront utiliser à bon escient cette connaissance.

L’automatisation sera ainsi naturellement la solution puisque de même que la croissance matérielle est finie alors que celle de l’information ne l’est pas, la croissance de production de data scientists est limitée, à la différence de celle du besoin d’analyser toujours plus de données de plus en plus finement.

Bien sûr les données de l’entreprise vont être de plus en plus diverses et volumineuses. Bien sûr elles seront stockées massivement donc plus aisément disponibles. Mais les gisements d’efficacité et de croissance ne passeront pas par le big data, du moins pas exclusivement. Seul le traitement intelligent de ces données, le smart data, permettra à l’entreprise d’améliorer son efficacité. Et l’automatisation de la data science sera très certainement le déclencheur qui permettra à toutes les entreprises d’entrer de plain-pied dans l’ère de l’optimisation par la data et de sortir enfin de l’illettrisme analytique.

Il y a moins de 5 ans, data scientist était classé dans le top 10 des métiers les plus demandés de la décennie à venir. Aujourd’hui on est un peu revenu de cet engouement. Le data scientist expérimenté sera certainement important dans une entreprise, mais il semble de plus en plus évident qu’il y aura moins besoin d’une armée de data scientists que d’une équipe d’analystes métier capable de digérer et consommer (et non de réaliser) les analyses qui seront le plus souvent produites par les algorithmes automatisés. Ce qui est d’ailleurs une bonne nouvelle puisque, s’il est difficile de trouver un data scientist dans une entreprise du fait de sa rareté et de son coût, on trouve pléthore d’analystes métier talentueux qui sauront utiliser à bon escient cette connaissance.

L’automatisation sera ainsi naturellement la solution puisque de même que la croissance matérielle est finie alors que celle de l’information ne l’est pas, la croissance de production de data scientists est limitée, à la différence de celle du besoin d’analyser toujours plus de données de plus en plus finement.

Bien sûr les données de l’entreprise vont être de plus en plus diverses et volumineuses. Bien sûr elles seront stockées massivement donc plus aisément disponibles. Mais les gisements d’efficacité et de croissance ne passeront pas par le big data, du moins pas exclusivement. Seul le traitement intelligent de ces données, le smart data, permettra à l’entreprise d’améliorer son efficacité. Et l’automatisation de la data science sera très certainement le déclencheur qui permettra à toutes les entreprises d’entrer de plain-pied dans l’ère de l’optimisation par la data et de sortir enfin de l’illettrisme analytique.

Autres articles

-

Selon une étude de Progress, 64 % des entreprises françaises souffrent de biais de données

-

Podcast: Mehdi Chouiten, Datategy annonce une nouvelle plateforme de data science

-

Podcast: Ramzi Larbi, fondateur de VA2CS

-

Atos QLM, le simulateur quantique d’Atos, fait son entrée au Japon

-

[Promotion] Livre Blanc Alteryx : La science des données en pratique