Voitures communicantes, compteurs intelligents ou encore étiquettes RFID, les objets connectés vont se multiplier autour de nous. L’iDate a récemment publié une étude qui en annonce 80 milliards dans le monde d’ici 2020 dans le monde d’ici 2020. Autant d’objets avec plus ou moins de puissance embarquée mais qui vont surtout communiquer des données que leurs fabricants ou que des opérateurs de services vont devoir collecter, stocker et surtout analyser. ABI Research estime que ce marché de l’analytique du M2M atteindra en 2013 1,9 milliard de dollars atteindra en 2013 1,9 milliard de dollars, mais plus de 14 milliards en 2018. Un défi technique en termes de volumétrie, de vélocité, de véracité, une mission pour le Big Data.

Linky, une évaluation à grande échelle

Le déploiement de parc de millions de compteurs intelligents, 3,5 millions pour l’espagnol Endeca, rend le déploiement d’infrastructures Big Data indispensable pour les fournisseurs d’électricité.

L’un des projets les plus ambitieux en France, le déploiement des 35 millions de compteurs intelligents Linky, a donné lieu à une évaluation poussée des solutions Big Data par le groupe EDF R&D Sigma. L’expérimentation visait à valider les configurations qui vont recueillir toutes les données émises par ces compteurs. Avec une mesure toutes les 10 minutes, à multiplier par 35 millions de compteurs, ce sont 1800 milliards d’enregistrement qui devront être stockés chaque année, soit 120 To de données brutes. La configuration cible doit bien évidement être capable de stocker les données arrivant au fil de l’eau, effectuer des prétraitements sur ces données, et surtout permettre des requêtes tant planifiées que des requêtes ad-Hoc. Outre des bases de données relationnelles classiques, l’expérimentation a validé une configuration Hadoop. Les données ont été stockées sur le système de fichier HDFS avant d’alimenter un data warehouse sur Hive stockant 11 mois de données. Les 3 derniers mois sont ensuite chargés dans une base de données HBase pour permettre le requetage ‘tactique’. Avec un cluster de 20 nœuds (336 cœurs de calcul), les résultats ont été jugés bons par l’équipe de test : une requête sur 7 jours de consommation globale (l’ensemble des 35 millions de compteurs) a été exécutée en 19 mn 24 s sur Hive, une requête Ad-hoc en 3 heures 16 min. Hive supportait jusqu’à 211 requêtes Ad-hoc sur 10 minutes de données et 0,95 requête simultanée sur des données d’un trimestre.

Le relationnel fait de la résistance

Photo wikimedia commons par flightlog - Autolib trace la position de ses 2000 véhicules. Une volumétrie compatible avec les bases de données relationnelles.

Les tests d’EDR R&D ont démontré que la configuration Hadoop pouvait tenir le choc des 35 millions de compteurs. Déjà quelques opérateurs de réseaux électriques américains, à l’image de Duke Energy ou la Tennessee Valley Authority ont fait ce choix technique d’Hadoop. Des déploiements toutefois bien plus limités que ce s’apprête à réaliser ERDF, l’exploitant du réseau électrique français. Ils ont finalement joué une certaine forme de sécurité en optant pour une valeur sure, l’entrepôt de données, Teradata. Le communiqué du 22 octobre 2013 annonce ce choix d’ERDF sans toutefois détailler la configuration qui sera déployée au final.

Car pour l’heure, les approches nouvelles, qu’il s’agisse des bases NoSQL ou Hadoop et Map/Reduce, sont loin de s’être imposées dans le M2M. Ainsi, Sylvain Géron, directeur associé de Polyconseil, l’entité informatique d’Autolib, le service parisien de location de voitures électriques, souligne : « Gérer des données en grand volume, on fait cela depuis près de 30 ans ! Il y a un ‘hype’ sur des choses qui n’ont rien de nouveau. Sur Autolib, j’ai beaucoup de données, notamment les données de géolocalisation de nos véhicules, les bornes. On a des données qui remontent en permanence afin de les superviser, assurer la maintenance. On n’est pas Coyote, par exemple, qui suit des millions de véhicules. Nous, on suit 2000 véhicules. » Autolib analyse les données de géolocalisation pour optimiser le positionnement de ses véhicules dans les stations de recharge et réaliser un équilibrage du parc de véhicules pour faire en sorte qu’il y ait toujours des voitures dans chaque arrondissement de Paris. « D’un point de vue technique, il n’y a aucune impossibilité à gérer des bases de données de n’importe quelle taille avec des bases de données relationnelles. C’est une mode que de dire que les bases de données non relationnelles seules permettent de gérer les grands volumes. On pourra aujourd’hui faire face à une multiplication par 100, par 1000 de notre parc de véhicules sans remettre en cause notre approche. »

Car pour l’heure, les approches nouvelles, qu’il s’agisse des bases NoSQL ou Hadoop et Map/Reduce, sont loin de s’être imposées dans le M2M. Ainsi, Sylvain Géron, directeur associé de Polyconseil, l’entité informatique d’Autolib, le service parisien de location de voitures électriques, souligne : « Gérer des données en grand volume, on fait cela depuis près de 30 ans ! Il y a un ‘hype’ sur des choses qui n’ont rien de nouveau. Sur Autolib, j’ai beaucoup de données, notamment les données de géolocalisation de nos véhicules, les bornes. On a des données qui remontent en permanence afin de les superviser, assurer la maintenance. On n’est pas Coyote, par exemple, qui suit des millions de véhicules. Nous, on suit 2000 véhicules. » Autolib analyse les données de géolocalisation pour optimiser le positionnement de ses véhicules dans les stations de recharge et réaliser un équilibrage du parc de véhicules pour faire en sorte qu’il y ait toujours des voitures dans chaque arrondissement de Paris. « D’un point de vue technique, il n’y a aucune impossibilité à gérer des bases de données de n’importe quelle taille avec des bases de données relationnelles. C’est une mode que de dire que les bases de données non relationnelles seules permettent de gérer les grands volumes. On pourra aujourd’hui faire face à une multiplication par 100, par 1000 de notre parc de véhicules sans remettre en cause notre approche. »

Big Data pour l’Internet des objets synonyme de Cloud ?

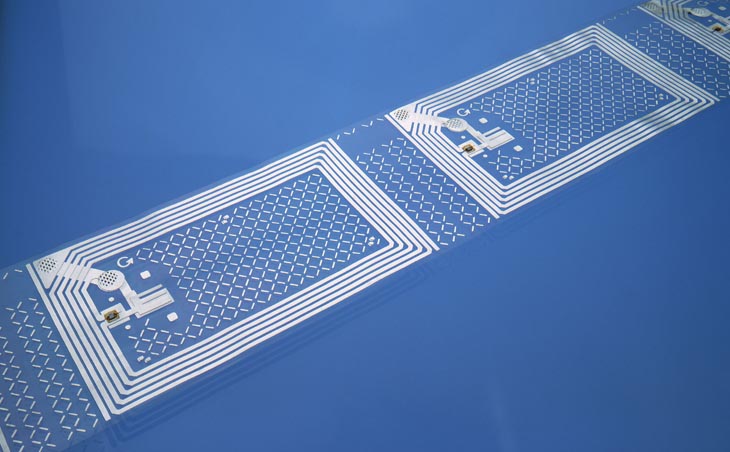

La généralisation des étiquettes RFID dans la Supply Chain va engendrer une explosion des volumes de données à traiter par les industriels ou les grandes enseignes de la distribution.

Pour Romain Chaumais, co-fondateur d’Ysance, les bases relationnelles finissent tout de même par atteindre leurs limites sur les très grosses volumétries engendrées par l’Internet des Objets : « C’est vrai, les bases relationnelles sont capables de stocker de gros volumes de données. Actuellement, les entreprises de distribution savent gérer plusieurs semaines d’historique de tickets de caisse dans leurs bases relationnelles, jusqu’à un ou deux mois. Au-delà, les bases traditionnelles s’écroulent. On peut toujours stocker, mais le requetage devient inutilisable ! » Il prend l’exemple d’une célèbre enseigne de la distribution spécialisée française qui, dans le cadre d’un vaste projet de déploiement d’étiquettes RFID, est en train d’étudier cet après-relationnel. « S’ils ont pu démarrer sur une base relationnelle, ils sont maintenant à la recherche d’une architecture cible qui va pouvoir absorber les volumes de données générés par ces puces. » confie Romain Chaumais. Ce sont plusieurs milliards d’événements qui vont être collectés puisque c’est l’intégralité du parcours logistique des produits qui va être tracé, depuis l’arrivée des produits sur palette, la mise en place dans les rayons, les passages en caisses et même les éventuels retours. Face à ce besoin de stockage et d’analyse, les architectes d’Ysance ont opté pour une solution Big Data dans le Cloud. « Selon moi, pour les applications d’Internet des Objets, Big Data et Cloud sont intimement liés » argumente Romain Chaumais. « Il est très difficile d’anticiper les volumétries de ce type d’application et, en cela, la souplesse du Cloud est particulièrement adaptée. Pour ce projet, nous avons proposé une architecture basée sur le service de Data warehouse Cloud Redshift d’Amazon Web Services. »

D’autres choisissent des bases de données de nouvelle génération. Yassine Faihe, expert Big Data Analytics chez HP Vertica, revendique deux clients en Europe pour sa base de données HP Vertica sur des applications M2M : « Nous positionnons Vertica notamment pour les applications de smart metering. Les données sont chargées dans la base pour analyser les données de consommations des foyers, des régions afin d’anticiper les pics de demande, éviter les délestages. Tout comme les bases relationnelles, Vertica est une base SQL, mais avec des capacités de gérer de très grosses masses de données, des milliards d’enregistrements. Son stockage en colonnes a pour effet immédiat d’accélérer les échanges dans un environnement distribué. Vertica supporte le ‘scale out’ offrant une scalabilité linéaire : on double le nombre de serveurs, on double les capacités de la base. C’est ce qui fait que Vertica peut gérer de très grandes masses de données. » Yassine Faihe estime que Vertica n’est pas en concurrence directe avec les bases Hadoop : « Vertica assure la performance, le temps réel, alors qu’Hadoop assure des traitements distribués, très robuste, sur un mode batch. » Un connecteur Hadoop permet à la base de communiquer avec un cluster Hadoop.

D’autres choisissent des bases de données de nouvelle génération. Yassine Faihe, expert Big Data Analytics chez HP Vertica, revendique deux clients en Europe pour sa base de données HP Vertica sur des applications M2M : « Nous positionnons Vertica notamment pour les applications de smart metering. Les données sont chargées dans la base pour analyser les données de consommations des foyers, des régions afin d’anticiper les pics de demande, éviter les délestages. Tout comme les bases relationnelles, Vertica est une base SQL, mais avec des capacités de gérer de très grosses masses de données, des milliards d’enregistrements. Son stockage en colonnes a pour effet immédiat d’accélérer les échanges dans un environnement distribué. Vertica supporte le ‘scale out’ offrant une scalabilité linéaire : on double le nombre de serveurs, on double les capacités de la base. C’est ce qui fait que Vertica peut gérer de très grandes masses de données. » Yassine Faihe estime que Vertica n’est pas en concurrence directe avec les bases Hadoop : « Vertica assure la performance, le temps réel, alors qu’Hadoop assure des traitements distribués, très robuste, sur un mode batch. » Un connecteur Hadoop permet à la base de communiquer avec un cluster Hadoop.

Vers la fin d’une architecture centrée sur la base de données

Pour parer à tout revirement du marché, Oracle a multiplié ces dernières années les lancements d’appliances : in-memory, NoSQL, Big data, appliance analytique, le géant rouge est omniprésent sur chaque segment de marché. Et chez Oracle, on considère que les architectures Big Data de demain seront basées, non pas sur l’un ou l’autre de ces composants, mais sur l’ensemble. Y compris sur un volet temps réel où le Complex Event Processing va venir se placer en amont du M2M. C’est cette brique qui va intercepter les messages, réagir en temps réel, réaliser les premiers traitements, puis passer la main du Big Data pur et dur. Jérôme Marc, consultant avant-vente Oracle sur le middleware explique la position de l’éditeur sur ce type d’architectures : « Hadoop permet de faire du stockage et Map Reduce permet principalement du faire du Batch. Quand on veut analyser des données en temps réel, on ne peut pas le faire avec Map Reduce. Si on veut analyser des plaques d’immatriculation en temps réel à partir de flux vidéo, par exemple, on entre dans ce qu’on appelle le fast data. » Une application pour laquelle Oracle suggère de placer Oracle Event Processing (OEP) en amont de son appliance Big Data. C’est ce qu’a réalisé l’opérateur japonais NTT Docomo qui analyse jusqu’à 700.000 messages par seconde pour étudier le comportement des abonnés de son réseau mobile.

La problématique technique semble résolue, mais…

Orange Business Services participe à de nombreux projets dans l’eSanté où sa plateforme M2M est sollicitée, c’est le cas avec Weinmann pour le suivi des apnées du sommeil, ou dans le suivi temps réel des diabétiques dans l’expérimentation M-Health Grand Tour.

Les experts considèrent qu’aujourd’hui les briques technologiques du M2M et de son volet analytique sont pleinement opérationnelles. Orange Business Services, par exemple, travaille avec Atos et Renault sur la voiture connectée, de même qu’il propose sa plateforme de développement d’applications M2M « Intelligent Apps Enabler » dans le cadre de l’application homecareONLINE, un appareil connecté qui permet de suivre à distance l’apnée du sommeil chez des patients. Capgemini a ainsi développé une plateforme M2M baptisée e-Objects, une plateforme de traitement des messages issus du M2M que la SSII française positionne notamment sur les applications de compteurs intelligents.

Pour Cédric Cormont, architecte et responsable bases de données dans l’activité Aéronautique et spatial chez Capgemini, un habitué au traitement des données générées en très gros volumes par les satellites ou par les instruments d’essai en vol des prototypes, l’enjeu est ailleurs : « La technique est prête, elle est puissante, scalable. On assiste aujourd’hui à une convergence entre le M2M et les technologies Big Data pour l’acquisition, le stockage et l’analyse de ces données. Le Big Data va permettre de décloisonner les informations jusqu’à maintenant stockées dans des silos. Ce qui manque aujourd’hui, ce sont des gens qui comprennent les données, qui sont capables de les analyser, les Data Scientists. » Thierry Picard, DGA de Spikly, l’agence digitale de Keyrus ajoute : « Ce qui change, ce sont les outils de data discovery ainsi que les modèles qui sont mis en œuvre. Ce sont des modèles stochastiques qui sont mis en œuvre pour identifier les comportements, par exemple. En France, on en est encore à l’évangélisation sur ce type d’approche et les projets en sont encore souvent d’au stade des études de faisabilité. »

Pour Cédric Cormont, architecte et responsable bases de données dans l’activité Aéronautique et spatial chez Capgemini, un habitué au traitement des données générées en très gros volumes par les satellites ou par les instruments d’essai en vol des prototypes, l’enjeu est ailleurs : « La technique est prête, elle est puissante, scalable. On assiste aujourd’hui à une convergence entre le M2M et les technologies Big Data pour l’acquisition, le stockage et l’analyse de ces données. Le Big Data va permettre de décloisonner les informations jusqu’à maintenant stockées dans des silos. Ce qui manque aujourd’hui, ce sont des gens qui comprennent les données, qui sont capables de les analyser, les Data Scientists. » Thierry Picard, DGA de Spikly, l’agence digitale de Keyrus ajoute : « Ce qui change, ce sont les outils de data discovery ainsi que les modèles qui sont mis en œuvre. Ce sont des modèles stochastiques qui sont mis en œuvre pour identifier les comportements, par exemple. En France, on en est encore à l’évangélisation sur ce type d’approche et les projets en sont encore souvent d’au stade des études de faisabilité. »

Autres articles

-

World Quality Report 2024 : 68% des entreprises utilisent désormais l'IA pour améliorer l'ingénierie de la qualité

-

Databricks renforce son partenariat avec AWS pour offrir des capacités avancées d'IA générative

-

Teradata facilite l’application concrète de l’IA générative et accélère la création de valeur pour les entreprises

-

Teradata propose des capacités d’IA exceptionnelles pour les grandes entreprises et les environnements hybrides en collaboration avec NVIDIA

-

Les nouvelles fonctionnalités de ClearScape Analytics maximisent le retour sur investissement en matière d’IA/ML et renforcent la productivité de la data science